Các nhà nghiên cứu của Đại học Thanh Hoa và Microsoft huấn luyện mô hình AI bằng dữ liệu tổng hợp, sử dụng chip Nvidia

Nhóm nghiên cứu từ Đại học Thanh Hoa (Tsinghua University) và Microsoft đã phát triển một quy trình dữ liệu tổng hợp để huấn luyện các mô hình trí tuệ nhân tạo mà không cần sử dụng dữ liệu thực tế, với sức mạnh tính toán đến từ các chip của Nvidia.

Ảnh minh họa

Quy trình này, mang tên SynthSmith, đã giúp tạo ra một mô hình lập trình quy mô nhỏ nhưng cho hiệu năng vượt trội so với những mô hình lớn gấp đôi, qua đó mở ra hướng đi mới nhằm giải quyết bài toán khan hiếm dữ liệu thực – một trong những rào cản lớn nhất trong việc cải thiện các mô hình AI hiện nay. Nghiên cứu được công bố trên kho truy cập mở arXiv ngày 11/1.

“Phân tích chuyên sâu cho thấy các quy luật mở rộng (scaling laws) vẫn giữ nguyên hiệu lực trên bộ dữ liệu tổng hợp của chúng tôi,” nhóm tác giả đến từ Đại học Thanh Hoa, Microsoft Research Asia và Đại học Vũ Hán cho biết.

Dữ liệu tổng hợp là loại dữ liệu được tạo ra bởi các thuật toán AI, mô phỏng đặc điểm của dữ liệu trong thế giới thực. Trong bối cảnh nguồn dữ liệu thực ngày càng cạn kiệt, giới nghiên cứu AI đang thử nghiệm dữ liệu tổng hợp như một cách để tiếp tục nâng cao năng lực mô hình.

Với SynthSmith, nhóm nghiên cứu đã huấn luyện mô hình X-Coder có 7 tỷ tham số nhưng đạt điểm số cao hơn các mô hình 14 tỷ tham số trên những bài kiểm tra lập trình phổ biến, dù sử dụng ít dữ liệu hơn và hoàn toàn không dựa vào dữ liệu thực, theo nội dung bài nghiên cứu.

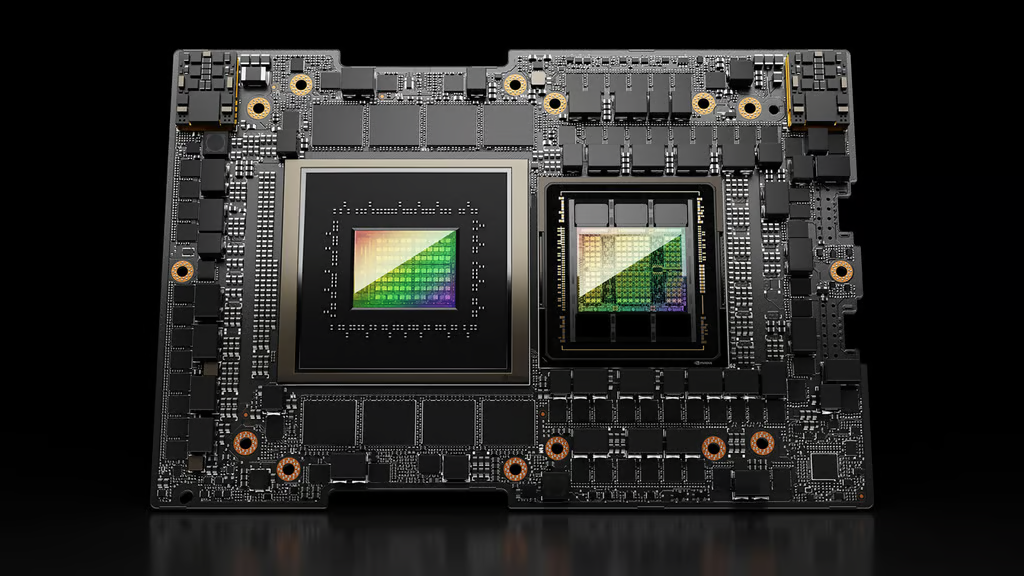

Chip Nvidia H20 và H200 cung cấp năng lực tính toán cho thí nghiệm. Ảnh: Nvidia

Để thực hiện thí nghiệm, nhóm đã sử dụng 128 chip Nvidia H20 trong 220 giờ ở giai đoạn tinh chỉnh có giám sát (supervised fine-tuning), cùng 32 chip Nvidia H200 trong bảy ngày cho giai đoạn huấn luyện tăng cường (reinforcement learning).

Trong bối cảnh ngành AI đang chuyển dịch sang các mô hình suy luận chủ động (agentic reasoning) – tức các hệ thống “suy nghĩ” trước khi tạo ra câu trả lời và có khả năng thực hiện nhiệm vụ trong thời gian dài – trọng tâm ngày càng dồn vào việc mở rộng tài nguyên tính toán cho giai đoạn suy luận và triển khai, thay vì chỉ tập trung vào huấn luyện ban đầu.

Wu Jie, tác giả chính của nghiên cứu và là học viên thạc sĩ tại Đại học Thanh Hoa, cho biết lý do chính khiến phương pháp này chưa được mở rộng cho các mô hình khổng lồ, có quy mô trên 100 tỷ hoặc hàng nghìn tỷ tham số, là do hạn chế về năng lực tính toán, chứ không phải do giới hạn của bản thân quy trình SynthSmith.

Thông qua việc công bố mã nguồn mở, nhóm nghiên cứu kỳ vọng cộng đồng khoa học có thể tiếp tục mở rộng và phát triển công trình này mà không phải gánh chi phí huấn luyện lớn.

Đáng chú ý, chính quyền Mỹ dưới thời Tổng thống Donald Trump đã cho phép các công ty Trung Quốc tiếp cận trở lại hai dòng chip H20 và H200 sau quá trình vận động hành lang kéo dài của Nvidia nhằm nới lỏng các biện pháp kiểm soát xuất khẩu. Trong đó, H20 được tối ưu cho suy luận mô hình, còn H200 là bộ xử lý AI mạnh nhất hiện nay mà các công ty AI Trung Quốc có thể sử dụng để huấn luyện những mô hình tiên tiến.