ChatGPT không ngốn điện như người ta từng nghĩ

Theo một nghiên cứu mới, ChatGPT - nền tảng chatbot của OpenAI không quá ngốn điện như người ta từng nghĩ. Nhưng nhu cầu của nó phần lớn phụ thuộc vào cách ChatGPT được sử dụng và các mô hình AI trả lời các truy vấn.

Phân tích gần đây của Epoch AI, một viện nghiên cứu AI phi lợi nhuận, đã cố gắng tính toán lượng năng lượng mà một truy vấn ChatGPT thông thường tiêu thụ. Một số liệu thống kê thường được trích dẫn là ChatGPT cần khoảng 3 watt/giờ điện để trả lời một câu hỏi duy nhất hoặc gấp 10 lần so với tìm kiếm trên Google. Epoch cho rằng đây là một ước tính quá cao.

Việc sử dụng mô hình mặc định mới nhất của OpenAI cho ChatGPT, GPT-4o, làm tài liệu tham khảo, Epoch phát hiện ra rằng truy vấn ChatGPT trung bình tiêu thụ khoảng 0,3 watt/giờ ít hơn nhiều thiết bị gia dụng.

Joshua You, nhà phân tích dữ liệu tại Epoch, người đã tiến hành phân tích, chia sẻ với TechCrunch rằng: "Việc sử dụng năng lượng thực sự không phải là vấn đề lớn so với việc sử dụng các thiết bị thông thường hoặc sưởi ấm hoặc làm mát nhà cửa, hoặc lái xe ô tô".

Việc sử dụng năng lượng của AI và tác động của nó đối với môi trường, nói chung là chủ đề của cuộc tranh luận gây tranh cãi khi các công ty AI tìm cách mở rộng nhanh chóng dấu chân cơ sở hạ tầng của họ. Chỉ tuần trước, một nhóm gồm hơn 100 tổ chức đã công bố một bức thư ngỏ kêu gọi ngành công nghiệp AI và các cơ quan quản lý đảm bảo rằng các trung tâm dữ liệu AI mới không làm cạn kiệt tài nguyên thiên nhiên và buộc các tiện ích phải dựa vào các nguồn năng lượng không tái tạo.

Bạn đã nói với TechCrunch rằng phân tích của ông được thúc đẩy bởi những gì ông mô tả là nghiên cứu trước đây đã lỗi thời. Ví dụ, bạn đã chỉ ra rằng tác giả của báo cáo đưa ra ước tính 3 watt/giờ cho rằng OpenAI đã sử dụng chip cũ hơn, kém hiệu quả hơn để chạy các mô hình của mình.

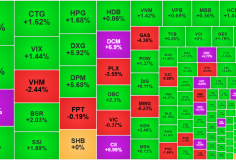

Nguồn hình ảnh: Epoch AI

Nguồn hình ảnh: Epoch AI

“Tôi đã thấy rất nhiều bài phát biểu công khai thừa nhận đúng đắn rằng AI sẽ tiêu thụ rất nhiều năng lượng trong những năm tới, nhưng không thực sự mô tả chính xác năng lượng mà AI đang sử dụng hiện nay”, You nói. “Ngoài ra, một số đồng nghiệp của tôi nhận thấy rằng ước tính được báo cáo rộng rãi nhất là 3 watt/giờ cho mỗi truy vấn dựa trên nghiên cứu khá cũ và dựa trên một số phép tính trên khăn ăn có vẻ quá cao”.

Thật vậy, con số 0,3 watt/giờ của Epoch cũng chỉ là con số gần đúng; OpenAI vẫn chưa công bố các chi tiết cần thiết để thực hiện phép tính chính xác.

Phân tích cũng không xem xét đến chi phí năng lượng bổ sung phát sinh do các tính năng ChatGPT như tạo hình ảnh hoặc xử lý đầu vào. Bạn thừa nhận rằng các truy vấn ChatGPT "đầu vào dài", ví dụ như các truy vấn có tệp đính kèm dài, có khả năng tiêu thụ nhiều điện hơn so với một câu hỏi thông thường.

Tuy nhiên, bạn đã nói rằng ông ấy mong đợi mức tiêu thụ điện năng cơ bản của ChatGPT sẽ tăng lên.

“AI sẽ trở nên tiên tiến hơn, việc đào tạo AI này có thể sẽ cần nhiều năng lượng hơn và AI trong tương lai có thể được sử dụng nhiều hơn nữa, xử lý nhiều tác vụ hơn và phức tạp hơn so với cách mọi người sử dụng ChatGPT hiện nay”, You cho biết.

Mặc dù đã có những đột phá đáng chú ý về hiệu quả AI trong những tháng gần đây, quy mô triển khai AI dự kiến sẽ thúc đẩy sự mở rộng cơ sở hạ tầng khổng lồ, ngốn nhiều điện năng. Theo báo cáo của Rand , trong hai năm tới, các trung tâm dữ liệu AI có thể cần gần như toàn bộ công suất điện năm 2022 của California (68 GW) . Đến năm 2030, việc đào tạo một mô hình biên giới có thể đòi hỏi sản lượng điện tương đương với tám lò phản ứng hạt nhân (8 GW), báo cáo dự đoán.

Chỉ riêng ChatGPT đã tiếp cận được một lượng người dùng khổng lồ và ngày càng tăng, khiến nhu cầu về máy chủ của họ cũng lớn tương tự. OpenAI, cùng với một số đối tác đầu tư, có kế hoạch chi hàng tỷ đô la cho các dự án trung tâm dữ liệu AI mới trong vài năm tới.

Sự chú ý của OpenAI, cùng với phần còn lại của ngành công nghiệp AI cũng đang chuyển sang các mô hình lý luận, thường có khả năng hơn về các nhiệm vụ mà chúng có thể hoàn thành nhưng đòi hỏi nhiều tính toán hơn để chạy. Trái ngược với các mô hình như GPT-4o, phản hồi các truy vấn gần như ngay lập tức, các mô hình lý luận "suy nghĩ" trong vài giây đến vài phút trước khi trả lời, một quá trình ngốn nhiều tính toán hơn và do đó tốn nhiều năng lượng hơn.

You cho biết: “Các mô hình lý luận sẽ ngày càng đảm nhận nhiều nhiệm vụ mà các mô hình cũ không thể thực hiện được và tạo ra nhiều [dữ liệu] hơn để thực hiện việc đó, và cả hai đều yêu cầu nhiều trung tâm dữ liệu hơn”.

OpenAI đã bắt đầu phát hành các mô hình lý luận tiết kiệm năng lượng hơn như o3-mini . Nhưng có vẻ như, ít nhất là tại thời điểm này, rằng hiệu quả tăng lên sẽ không bù đắp được nhu cầu năng lượng tăng lên từ quá trình "suy nghĩ" của các mô hình lý luận và việc sử dụng AI ngày càng tăng trên toàn thế giới.

Bạn gợi ý rằng những người lo lắng về dấu chân năng lượng AI của mình nên sử dụng các ứng dụng như ChatGPT ít thường xuyên hoặc chọn các mô hình giảm thiểu việc tính toán cần thiết ở mức độ thực tế.

“Bạn có thể thử sử dụng các mô hình AI nhỏ hơn như GPT-4o-mini của [OpenAI],” You nói, “và sử dụng chúng một cách tiết kiệm theo cách đòi hỏi phải xử lý hoặc tạo ra một lượng lớn dữ liệu.”