Giải mã lợi ích và hạn chế trong tối ưu hóa AI

Một trong những kỹ thuật phổ biến nhất nhằm nâng cao hiệu quả cho các mô hình AI là lượng tử hóa, nhưng kỹ thuật này không phải không có giới hạn và ngành công nghiệp có thể sớm chạm đến những giới hạn đó.

Trong lĩnh vực AI, lượng tử hóa chính là việc giảm số lượng bit - đơn vị nhỏ nhất mà máy tính sử dụng để xử lý thông tin - cần thiết cho việc biểu diễn dữ liệu. Để minh họa, hãy tưởng tượng khi ai đó hỏi bạn giờ, bạn có thể đơn giản trả lời "trưa" thay vì phải nói "một nghìn hai trăm, một giây và bốn mili giây". Cả hai cách đều đúng, nhưng câu trả lời đầu tiên rõ ràng là ngắn gọn và dễ hiểu hơn. Mức độ chính xác cần thiết phụ thuộc vào từng tình huống cụ thể.

Trong các mô hình AI, có một số thành phần có thể được lượng tử hóa - đặc biệt là các tham số, tức là các biến nội bộ mà mô hình sử dụng để đưa ra dự đoán hoặc quyết định. Điều này rất hữu ích, vì các mô hình thường phải thực hiện hàng triệu phép toán mỗi giây. Khi lượng tử hóa, các mô hình sử dụng ít bit hơn để biểu diễn các tham số của chúng, từ đó giảm bớt yêu cầu về khối lượng tính toán. Tuy nhiên, cần lưu ý rằng lượng tử hóa khác với "chưng cất", mà là quá trình tinh lọc các tham số một cách có chọn lọc.

Nguồn hình ảnh: Hình ảnh Getty

Tuy nhiên, lượng tử hóa cũng đi kèm với những đánh đổi không thể xem nhẹ. Khi nỗ lực tối ưu hóa mô hình, việc giảm số bit sử dụng có thể dẫn đến việc mất mát thông tin quan trọng, ảnh hưởng đến độ chính xác và hiệu suất của mô hình. Do đó, điều quan trọng là phải cân nhắc giữa việc tiết kiệm tài nguyên tính toán và việc duy trì hiệu quả thông tin.

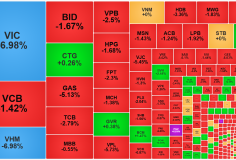

Mô hình ngày càng thu hẹp

Theo một nghiên cứu từ các nhà nghiên cứu hàng đầu tại Harvard, Stanford, MIT, Databricks và Carnegie Mellon, các mô hình AI được lượng tử hóa có xu hướng hoạt động kém hiệu quả hơn nếu phiên bản gốc chưa được lượng tử hóa đã được đào tạo kéo dài trên một lượng lớn dữ liệu. Điều này thực sự đặt ra câu hỏi: liệu có phải tốt hơn khi chỉ tập trung đào tạo một mô hình nhỏ hơn, thay vì cố gắng tối ưu hóa một mô hình lớn đã qua xử lý?

Điều này chắc chắn là tin không vui cho những công ty AI đang theo đuổi việc phát triển mô hình cực lớn. Những mô hình lớn này, mặc dù được cho rằng cải thiện hiệu suất và độ chính xác, nhưng đang gặp phải thách thức khi phải lượng tử hóa để giảm thiểu chi phí khi triển khai.

Gần đây, các nhà phát triển và học giả đã báo cáo rằng việc lượng tử hóa mô hình Llama 3 của Meta có thể mang lại kết quả "kém hơn" so với các mô hình khác, nguyên nhân có thể là do cách mà mô hình này được đào tạo. Tanishq Kumar, một sinh viên toán học tại Harvard và là tác giả chính của bài báo, chia sẻ rằng: “Chi phí lớn nhất trong lĩnh vực AI sẽ vẫn luôn là chi phí suy luận và nghiên cứu của chúng tôi chỉ ra rằng việc giảm chi phí này sẽ không còn hiệu quả mãi mãi”.

Trái với quan niệm trước đây, việc chạy một mô hình AI - như khi ChatGPT trả lời câu hỏi - lại thường tốn kém hơn nhiều so với việc đào tạo mô hình đó. Chẳng hạn, Google đã chi khoảng 191 triệu đô la để đào tạo một trong những mô hình Gemini hàng đầu của mình. Tuy nhiên, nếu công ty này sử dụng một mô hình để tạo ra ba câu trả lời chỉ gồm 50 từ cho nửa số truy vấn tìm kiếm của họ, thì chi phí hàng năm có thể lên tới khoảng 6 tỷ đô la.

Các phòng thí nghiệm AI lớn đã nhanh chóng áp dụng mô hình đào tạo trên các tập dữ liệu khổng lồ với hy vọng rằng việc "mở rộng quy mô" - tức là gia tăng khối lượng dữ liệu và sức mạnh tính toán trong quá trình đào tạo - sẽ dẫn đến những AI ngày càng mạnh mẽ hơn. Ví dụ, Meta đã đào tạo Llama 3 trên một bộ dữ liệu khổng lồ, gồm 15 nghìn tỷ token (mỗi triệu token tương đương khoảng 750.000 từ). So với thế hệ trước Llama 2, chỉ được đào tạo trên 2 nghìn tỷ token, sự tăng trưởng này rõ ràng là rất ấn tượng.

Tuy nhiên, có bằng chứng cho thấy việc mở rộng quy mô cuối cùng sẽ mang lại lợi nhuận giảm dần. Anthropic và Google được cho là đã đầu tư vào việc đào tạo những mô hình cực lớn gần đây, nhưng kết quả không đạt được các kỳ vọng chuẩn mực mà họ đặt ra. Dù vậy, vẫn chưa có dấu hiệu cho thấy ngành công nghiệp AI sẵn sàng từ bỏ những phỏng đoán như vậy. Sự khám phá này đưa ra thách thức lớn cho các nhà phát triển và nghiên cứu trong việc chuyển mình theo hướng hiệu quả hơn và bền vững hơn trong tương lai.

Chính xác đến mức nào?

Vậy nếu các phòng thí nghiệm không muốn giảm kích thước mô hình bằng cách đào tạo trên các tập dữ liệu nhỏ hơn, liệu có cách nào để làm cho các mô hình hoạt động hiệu quả mà không bị suy thoái không? Có thể! Tanishq Kumar và các đồng tác giả đã phát hiện rằng việc đào tạo các mô hình với “độ chính xác thấp” có thể tạo ra những kết quả tốt hơn. Hãy cùng tìm hiểu thêm về điều này.

"Độ chính xác" ở đây được hiểu là khả năng mô hình biểu diễn chính xác các con số. Đó là một cách nói về cách mà một kiểu dữ liệu số, như kiểu dữ liệu FP8, chỉ sử dụng 8 bit để lưu trữ một số dấu phẩy động. Hầu hết các mô hình hiện nay được đào tạo với độ chính xác 16 bit, hay còn gọi là "độ chính xác một nửa", và sau đó được lượng tử hóa thành 8 bit. Trong quá trình này, một số thành phần của mô hình (như các tham số) sẽ được chuyển đổi sang một định dạng có độ chính xác thấp hơn, dù điều này sẽ có thể gây ra những vấn đề về độ chính xác. Có thể hiểu như việc bạn tính toán đến một số chữ số thập phân nhưng sau đó làm tròn chúng, giúp giữ lại những gì tốt nhất mà không cần phải phức tạp hóa.

Hiện nay, các nhà cung cấp phần cứng như Nvidia đang thúc đẩy việc sử dụng độ chính xác thấp hơn trong suy luận mô hình. Chip Blackwell mới của họ hỗ trợ kiểu dữ liệu có độ chính xác chỉ 4 bit, còn được gọi là FP4. Điều này được xem là một lựa chọn hợp lý cho các trung tâm dữ liệu không có đủ bộ nhớ hoặc năng lượng.

Tuy nhiên, việc sử dụng độ chính xác cực thấp không hẳn là một giải pháp lý tưởng. Kumar cảnh báo rằng nếu mô hình gốc không đủ lớn về số lượng tham số, thì việc giảm độ chính xác xuống dưới 7 hoặc 8 bit có thể dẫn đến sự suy giảm chất lượng rõ rệt.

Nếu bạn cảm thấy những thông tin trên có phần kỹ thuật, đừng lo lắng - đúng là như vậy. Điều quan trọng mà chúng ta cần nhận thức là không thể đơn giản hóa hay bỏ qua các vấn đề trong việc phát triển mô hình AI. Như Kumar đã chỉ ra, “Có những giới hạn mà bạn không thể tự mãn vượt qua được.” Ông hi vọng rằng nghiên cứu này sẽ mang lại những cái nhìn sâu sắc hơn về việc sử dụng độ chính xác ngày càng thấp trong việc đào tạo và suy luận các mô hình.

Kumar cũng thừa nhận rằng quy mô của nghiên cứu này còn hạn chế và họ dự định sẽ thử nghiệm trên nhiều mô hình hơn trong tương lai. Tuy nhiên, ông tin rằng một điều chắc chắn là không có gì miễn phí khi giảm chi phí suy luận. “Độ chính xác của bit rất quan trọng và không thể cắt giảm mãi mà không ảnh hưởng tới mô hình,” ông nhấn mạnh.

Ông cho rằng, thay vì cố nhồi nhét một lượng lớn dữ liệu vào một mô hình nhỏ, các nhà phát triển nên đầu tư nhiều hơn vào việc tuyển chọn và lọc dữ liệu, nhằm chỉ đưa vào mô hình những dữ liệu chất lượng cao nhất. Kumar lạc quan rằng trong tương lai, những cấu trúc mới sẽ được phát triển để giúp quá trình đào tạo với độ chính xác thấp trở nên hiệu quả và ổn định hơn.