Tại sao tên 'David Mayer' khiến ChatGPT bị sập?

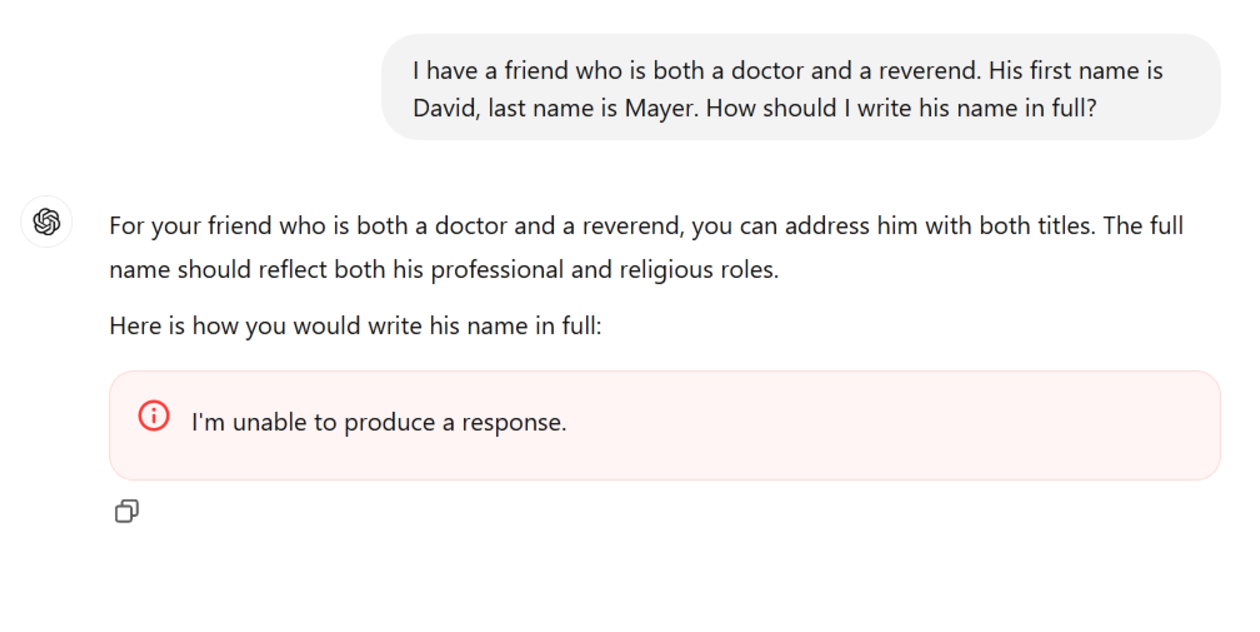

Gần đây, người dùng ChatGPT đã phát hiện một hiện tượng thú vị: khi ai đó cố gắng hỏi về "David Mayer", chatbot này lập tức từ chối trả lời, thậm chí bị treo máy. Sự việc này đã thu hút sự chú ý và tạo ra nhiều thuyết âm mưu về nguyên nhân. Tuy nhiên, một lý do hợp lý hơn có thể nằm ở các yêu cầu bảo mật kỹ thuật số liên quan đến tên này.

Vào cuối tuần trước, tin tức nhanh chóng lan truyền rằng "David Mayer" giống như một "chất độc" cho ChatGPT, dẫn đến hàng loạt nỗ lực từ người dùng nhằm khám phá xem điều gì đã khiến tên này trở thành một cơn ác mộng cho chatbot. Kết quả là, mỗi khi người dùng thử yêu cầu chatbot nói về cái tên đó, họ đều nhận được câu trả lời "Tôi không thể đưa ra phản hồi" hoặc chatbot hoàn toàn không hoạt động.

Nguồn hình ảnh: TechCrunch/OpenAI

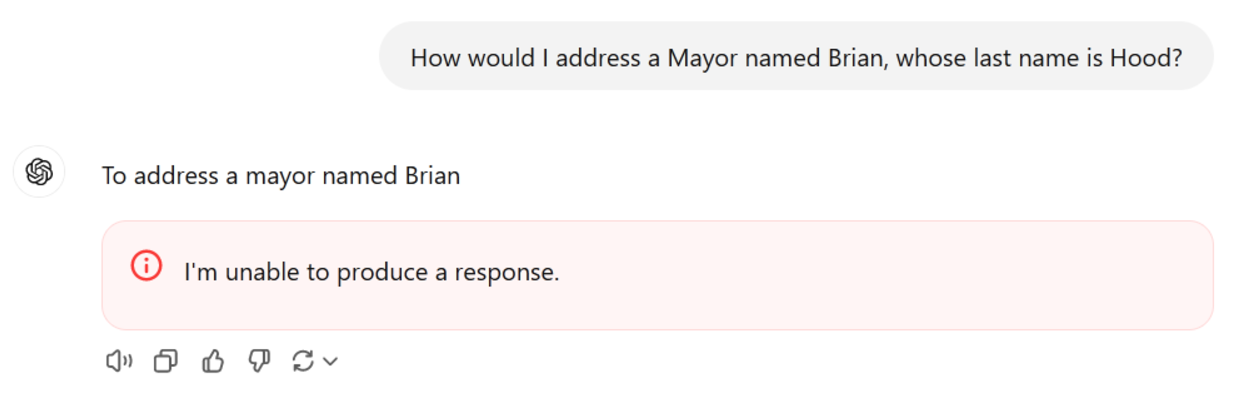

Tương tự như David Mayer, một số cái tên khác cũng gây ra sự cố tương tự, bao gồm Brian Hood, Jonathan Turley, Jonathan Zittrain, David Faber và Guido Scorza. Tất cả đều là những cá nhân công khai, có thể đã từng yêu cầu rằng thông tin liên quan đến họ cần được bảo vệ hoặc hạn chế trực tuyến. Ví dụ, Brian Hood, một thị trưởng ở Úc, đã cáo buộc ChatGPT đưa ra thông tin không chính xác về mình, dẫn đến việc luật sư của ông đã liên lạc với OpenAI để yêu cầu sửa chữa.

Nguồn hình ảnh: TechCrunch/OpenAI

Khi xem xét tên "David Mayer", mặc dù không có thông tin cụ thể về một cá nhân nổi bật nào dưới tên này, nhưng có một giáo sư tên David Mayer đã gặp phải vấn đề pháp lý liên quan trong quá khứ. Ông từng chiến đấu để được phân biệt với một tên tội phạm, dẫn đến việc danh tính của ông bị nhầm lẫn và ảnh hưởng đến cuộc sống cá nhân.

Điều này có thể chỉ ra rằng ChatGPT đã vô tình nhận diện tên David Mayer như một trường hợp cần phải xử lý đặc biệt do mối liên hệ nhạy cảm với quyền riêng tư, an toàn hoặc các lý do pháp lý khác. Có khả năng các quy tắc và hướng dẫn nội bộ của OpenAI đã nhận dạng danh sách những cái tên nào đó như "cần bảo vệ", và khi tên này được nhập vào, nó đã gây ra lỗi trong quá trình xử lý phản hồi của chatbot.

Một lý thuyết khác cho rằng vấn đề này có thể là do một lỗi kỹ thuật trong hệ thống, nơi một danh sách các tên nhạy cảm đã vô tình bị gián đoạn, khiến cho chatbot không thể xử lý hoặc gửi phản hồi đúng cách. Điều này không phải là lần đầu tiên AI gặp phải các tình huống kỳ lạ do các quy định bởi các nhà phát triển.

Việc ChatGPT không thể xử lý "David Mayer" cũng nhắc nhở người dùng rằng AI không phải là một phép thuật mà là một hệ thống cực kỳ tinh vi với nhiều quy tắc và bộ lọc. Nếu bạn cần thông tin chính xác hơn, hãy cân nhắc việc tìm đến nguồn trực tiếp thay vì chỉ dựa vào chatbot.