Intel và các công ty khác cam kết xây dựng các công cụ AI thế hệ mở cho doanh nghiệp

AI tạo ra được thiết kế cho doanh nghiệp (ví dụ: AI tự động hoàn thành báo cáo, công thức bảng tính, v.v.) có thể tương tác được không? Cùng với một nhóm các tổ chức bao gồm Cloudera và Intel, Linux Foundation – tổ chức phi lợi nhuận hỗ trợ và duy trì một số lượng ngày càng tăng các nỗ lực nguồn mở – nhằm mục đích tìm hiểu.

Nguồn ảnh: hapabapa

AI tạo ra được thiết kế cho doanh nghiệp (ví dụ: AI tự động hoàn thành báo cáo, công thức bảng tính, v.v.) có thể tương tác được không? Cùng với một nhóm các tổ chức bao gồm Cloudera và Intel, Linux Foundation – tổ chức phi lợi nhuận hỗ trợ và duy trì một số lượng ngày càng tăng các nỗ lực nguồn mở – nhằm mục đích tìm hiểu.

Quỹ Linux hôm thứ ba đã công bố sự ra mắt của Nền tảng mở cho AI doanh nghiệp (OPEA), một dự án để thúc đẩy sự phát triển của các hệ thống AI mở, đa nhà cung cấp và có thể kết hợp (tức là mô-đun). Dưới tầm nhìn của tổ chức LF AI và Dữ liệu của Linux Foundation, tập trung vào các sáng kiến nền tảng liên quan đến AI và dữ liệu, mục tiêu của OPEA sẽ là mở đường cho việc phát hành các hệ thống AI tạo ra "cứng", "có thể mở rộng" "khai thác sự đổi mới nguồn mở tốt nhất từ khắp hệ sinh thái", giám đốc điều hành của LF AI và Data, Ibrahim Haddad, cho biết trong một thông cáo báo chí.

"OPEA sẽ mở ra những khả năng mới trong AI bằng cách tạo ra một khuôn khổ chi tiết, có thể kết hợp, đi đầu trong các ngăn xếp công nghệ", Haddad nói. "Sáng kiến này là một minh chứng cho sứ mệnh của chúng tôi để thúc đẩy sự đổi mới và hợp tác nguồn mở trong cộng đồng AI và dữ liệu theo một mô hình quản trị mở và trung lập."

Ngoài Cloudera và Intel, OPEA - một trong những Dự án Sandbox của Linux Foundation, một chương trình ươm tạo - nằm trong số các thành viên nặng ký như Intel, Red Hat thuộc sở hữu của IBM, Hugging Face, Domino Data Lab, MariaDB và VMware.

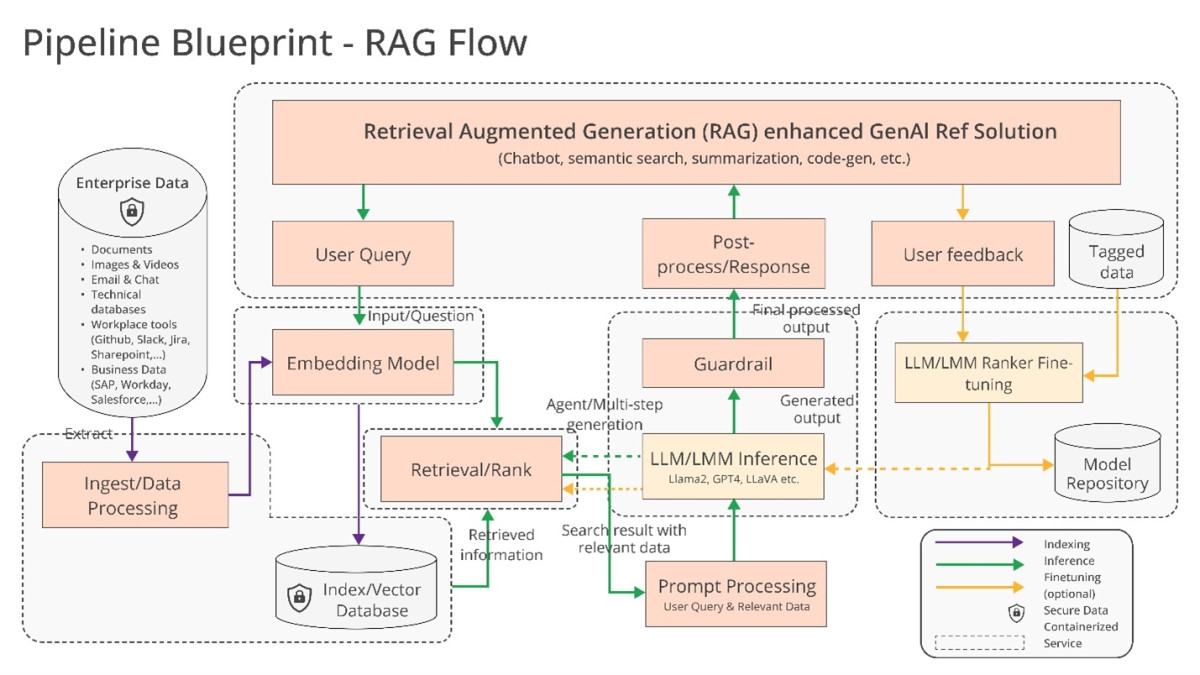

Vậy chính xác thì họ có thể xây dựng những gì cùng nhau? Haddad gợi ý một vài khả năng, chẳng hạn như hỗ trợ "tối ưu hóa" cho các chuỗi công cụ và trình biên dịch AI, cho phép khối lượng công việc AI chạy trên các thành phần phần cứng khác nhau, cũng như các đường ống "không đồng nhất" để tạo tăng cường truy xuất (RAG).

RAG đang ngày càng trở nên phổ biến trong các ứng dụng doanh nghiệp của AI tạo ra và không khó để hiểu tại sao. Hầu hết các câu trả lời và hành động của các mô hình AI tạo ra được giới hạn ở dữ liệu mà chúng được đào tạo. Nhưng với RAG, cơ sở kiến thức của mô hình có thể được mở rộng sang thông tin bên ngoài dữ liệu đào tạo ban đầu. Các mô hình RAG tham chiếu thông tin bên ngoài này - có thể ở dạng dữ liệu công ty độc quyền, cơ sở dữ liệu công khai hoặc kết hợp cả hai - trước khi tạo phản hồi hoặc thực hiện nhiệm vụ.

Sơ đồ giải thích các mô hình RAG. Nguồn ảnh: Intel

Intel đã cung cấp thêm một vài chi tiết trong thông cáo báo chí của riêng mình:

Các doanh nghiệp đang gặp thách thức với cách tiếp cận tự làm [đối với RAG] vì không có tiêu chuẩn thực tế nào trên các thành phần cho phép doanh nghiệp lựa chọn và triển khai các giải pháp RAG mở và có thể tương tác và giúp họ nhanh chóng tiếp cận thị trường. OPEA dự định giải quyết những vấn đề này bằng cách hợp tác với ngành để chuẩn hóa các thành phần, bao gồm các khung, bản thiết kế kiến trúc và giải pháp tham khảo.

Đánh giá cũng sẽ là một phần quan trọng trong những gì OPEA giải quyết.

Trong kho lưu trữ GitHub của mình, OPEA đề xuất một phiếu đánh giá để phân loại các hệ thống AI tạo ra theo bốn trục: hiệu suất, tính năng, độ tin cậy và mức độ sẵn sàng "cấp doanh nghiệp". Hiệu suất như OPEA định nghĩa nó liên quan đến điểm chuẩn "hộp đen" từ các trường hợp sử dụng trong thế giới thực. Các tính năng là sự đánh giá về khả năng tương tác, lựa chọn triển khai và tính dễ sử dụng của hệ thống. Độ tin cậy xem xét khả năng của mô hình AI để đảm bảo "mạnh mẽ" và chất lượng. Và sự sẵn sàng của doanh nghiệp tập trung vào các yêu cầu để có được một hệ thống và chạy mà không có các vấn đề lớn.

Rachel Roumeliotis, giám đốc chiến lược nguồn mở tại Intel, nói rằng OPEA sẽ làm việc với cộng đồng nguồn mở để cung cấp các bài kiểm tra dựa trên phiếu tự đánh giá, cũng như cung cấp các đánh giá và phân loại các triển khai AI tạo ra theo yêu cầu.

Những nỗ lực khác của OPEA đang có một chút lên không trung vào lúc này. Nhưng Haddad đã đưa ra tiềm năng phát triển mô hình mở dọc theo dòng họ Llama mở rộng của Meta và DBRX của Databricks. Để đạt được điều đó, trong repo OPEA, Intel đã đóng góp các triển khai tham chiếu cho một chatbot hỗ trợ AI tạo ra, trình tóm tắt tài liệu và trình tạo mã được tối ưu hóa cho phần cứng Xeon 6 và Gaudi 2 của mình.

Bây giờ, các thành viên của OPEA được đầu tư rất rõ ràng (và tư lợi, cho vấn đề đó) trong việc xây dựng công cụ cho AI tạo ra doanh nghiệp. Cloudera gần đây đã đưa ra quan hệ đối tác để tạo ra những gì nó quảng cáo là một "hệ sinh thái AI" trên đám mây. Domino cung cấp một bộ ứng dụng để xây dựng và kiểm toán AI tạo ra doanh nghiệp. Và VMware – hướng tới khía cạnh cơ sở hạ tầng của AI doanh nghiệp – tháng Tám năm ngoái đã tung ra các sản phẩm tính toán "AI riêng" mới.

Câu hỏi đặt ra là liệu các nhà cung cấp này có thực sự làm việc cùng nhau để xây dựng các công cụ AI tương thích chéo theo OPEA hay không.

Có một lợi ích rõ ràng khi làm như vậy. Khách hàng sẽ vui vẻ vẽ trên nhiều nhà cung cấp tùy thuộc vào nhu cầu, nguồn lực và ngân sách của họ. Nhưng lịch sử đã chỉ ra rằng tất cả đều quá dễ dàng để trở nên nghiêng về việc khóa nhà cung cấp. Hãy hy vọng đó không phải là kết quả cuối cùng ở đây.

Theo TechCrunch