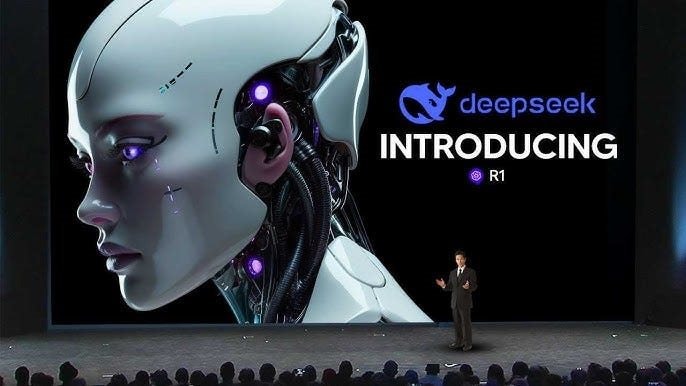

AI DeepSeek-R1: Bứt phá suy luận nhờ "phần thưởng"

Nhóm nghiên cứu sử dụng cơ chế phần thưởng để dạy DeepSeek AI giải quyết vấn đề, giúp vượt qua các rào cản huấn luyện truyền thống.

Được phát hành vào tháng 1/2025, mô hình mã nguồn mở do Công ty khởi nghiệp AI DeepSeek có trụ sở tại Hàng Châu phát triển đã gây chấn động ngành công nghiệp khi trở thành đối thủ cạnh tranh trực tiếp với mô hình o1 dẫn đầu của OpenAI tại Mỹ.

Trong bài báo đăng trên Tạp chí Nature ngày 17/9/2025, nhóm nghiên cứu DeepSeek AI đã tiết lộ cách họ sử dụng cơ chế phần thưởng (rewards) để huấn luyện mô hình R1 trong việc giải quyết các vấn đề, giúp khắc phục một số rào cản tốn kém về tính toán và mở rộng trong việc dạy AI suy luận giống con người.

“Khả năng suy luận tổng quát đại diện cho một thách thức lâu dài và khó khăn trong trí tuệ nhân tạo”, nhóm nghiên cứu cho biết.

Suy luận (reasoning), hay quá trình logic sử dụng kiến thức sẵn có cùng thông tin mới để đưa ra kết luận, là yếu tố trung tâm định hình nhận thức con người. Nó cho phép thực hiện các nhiệm vụ nhận thức phức tạp, bao gồm giải quyết vấn đề toán học, trở thành yếu tố then chốt trong việc phát triển AI tiên tiến mô phỏng tư duy và hành vi con người.

Sự phát triển của các mô hình ngôn ngữ lớn (LLM), có khả năng hiểu và tạo ra ngôn ngữ giống con người, đã đạt được thành công đáng kể trong các nhiệm vụ suy luận cơ bản. Tuy nhiên, thành công này phụ thuộc nhiều vào các dữ liệu huấn luyện được chú thích bởi con người và khả năng của mô hình vẫn chưa đủ để giải quyết những vấn đề phức tạp hơn, nhóm DeepSeek AI nhấn mạnh.

Điều này giới hạn khả năng mở rộng và có thể đưa thiên kiến con người vào quá trình huấn luyện mô hình. Bên cạnh đó, nó cũng tiềm ẩn nguy cơ hạn chế việc khám phá các phương pháp suy luận vượt trội ngoài khả năng của trí tuệ con người.

Học tăng cường: AI tự phát triển khả năng suy luận

Để vượt qua rào cản này, nhóm nghiên cứu đã sử dụng học tăng cường (reinforcement learning) để mô hình LLM tự phát triển khả năng suy luận thông qua quá trình tự tiến hóa.

Học tăng cường là một phương pháp trong đó một tác nhân hoặc mô hình học hỏi thông qua tương tác với môi trường bằng cách thử và sai, nhận được hình phạt hoặc phần thưởng cho từng hành động. Khi áp dụng vào một mô hình ngôn ngữ như DeepSeek, mỗi khi mô hình tạo ra kết quả phản hồi cho một đề bài, nó nhận được tín hiệu phản hồi dưới dạng phần thưởng, giúp cải thiện chất lượng câu trả lời.

Thay vì hướng dẫn mô hình cách giải quyết vấn đề, chúng tôi chỉ cung cấp các “khích lệ” phù hợp và mô hình tự phát triển các chiến lược giải quyết vấn đề nâng cao, các nhà nghiên cứu cho biết.

Điều này giúp họ bỏ qua giai đoạn tinh chỉnh có giám sát trong quá trình huấn luyện ban đầu, vốn sử dụng cơ sở dữ liệu các đề bài và câu trả lời lý tưởng do con người tạo ra để điều chỉnh mô hình.

Mô hình DeepSeek-R1 thu được, mặc dù vẫn cần một số giám sát của con người trong quá trình huấn luyện, đã đạt được “hiệu suất vượt trội” trong các cuộc thi toán học và lập trình, vượt trội so với các mô hình huấn luyện theo phương pháp truyền thống.

Sáng kiến này xuất phát từ giả thuyết rằng các mô hình suy luận do con người định nghĩa có thể hạn chế khả năng khám phá của mô hình, trong khi huấn luyện tự do thông qua học tăng cường có thể thúc đẩy sự xuất hiện các năng lực suy luận mới trong LLM, nhóm nghiên cứu giải thích.

Nhóm bắt đầu bằng cách áp dụng một quy trình học tăng cường hiệu quả vào mô hình cơ sở DeepSeek-V3, cho phép mô hình DeepSeek-R1-Zero phát triển tự nhiên các “hành vi suy luận đa dạng và tinh vi”.

Họ đã sử dụng nhiều chuẩn đánh giá trong quá trình huấn luyện, bao gồm Kỳ thi Toán Mời Quốc gia Hoa Kỳ 2024 (AIME). Mô hình DeepSeek-R1-Zero đã nâng điểm trung bình từ 15,6% lên 77,9% sau quá trình huấn luyện, vượt trội so với độ chính xác của thí sinh con người.

Tuy nhiên, mô hình này vẫn gặp phải những thách thức như trộn lẫn ngôn ngữ, do được huấn luyện bằng nhiều ngôn ngữ, bao gồm Trung Quốc và Anh.

Điều này khiến nhóm tiến hành huấn luyện thêm để phát triển mô hình DeepSeek-R1, kế thừa khả năng suy luận của phiên bản trước trong khi điều chỉnh hành vi gần gũi hơn với các ưu tiên của con người.

Mô hình này đạt tỷ lệ chính xác 79,8% trong AIME và cải thiện ở một số chuẩn đánh giá lập trình và toán học khác.

Tiềm năng lớn, rủi ro không nhỏ

Điều này cho thấy tiềm năng của học tăng cường trong việc mở khóa các năng lực cao hơn của LLM, mở đường cho các mô hình tự chủ và thích ứng hơn trong tương lai.

Nhóm nghiên cứu lưu ý rằng, sự tiến bộ trong khả năng suy luận cũng tiềm ẩn các rủi ro đạo đức, bao gồm khả năng xảy ra các cuộc tấn công “jailbreak”, lợi dụng các sơ hở của AI nhằm đánh lừa mô hình vượt qua các cơ chế an toàn sẵn có.

Mô hình vẫn còn một số hạn chế mà nhóm nghiên cứu hy vọng sẽ khắc phục trong tương lai, bao gồm việc không thể sử dụng các công cụ bên ngoài như máy tính để cải thiện hiệu suất và điểm số trên các chuẩn đánh giá kỹ thuật phần mềm./.