Tổng quan về Luật trí tuệ nhân tạo trên thế giới

Các quốc gia và khu vực trên thế giới đang phát triển nhiều khung pháp lý để quản lý trí tuệ nhân tạo (AI), với cách tiếp cận khác nhau nhằm cân bằng đổi mới và giảm thiểu rủi ro [1], [20].

Dưới đây là tổng quan chiến lược về luật và chính sách AI tại một số nơi tiêu biểu (Hoa Kỳ, Liên minh Châu Âu - EU, Trung Quốc, Hàn Quốc, Singapore, Malaysia) trong khoảng 3 năm gần đây (2023 - 2025), tập trung vào định nghĩa AI, nguyên tắc nền tảng, chiến lược thực thi, tiêu chuẩn đạo đức và an toàn, phân loại rủi ro, yêu cầu minh bạch, trách nhiệm giải trình, quản lý AI tạo sinh và chế tài xử phạt.

Hoa Kỳ

Hoa Kỳ hiện chưa có định nghĩa pháp lý thống nhất về AI ở cấp liên bang, trong khi đó, các dự luật khác nhau đang đề xuất định nghĩa riêng (ví dụ: Algorithmic Accountability Act, 2023).

Theo Báo cáo của Congressional Research Service (CRS), không có đạo luật liên bang nào thiết lập cơ quan quản lý thống nhất cho AI, và phần lớn việc giám sát được thực hiện bởi các cơ quan theo lĩnh vực” [11] [12]. Một số bang như California, Colorado, Connecticut và Illinois đã ban hành hoặc đề xuất luật về quyền riêng tư dữ liệu và quyết định tự động.

Ví dụ, Đạo luật Quyền riêng tư Người tiêu dùng California (CCPA, 2020) và các sửa đổi năm 2023 quy định quyền phản đối quyết định tự động” [19].

Một số điểm chính của Đạo luật:

Định nghĩa và phạm vi: Chưa có định nghĩa AI thống nhất cấp liên bang - các bang và dự luật khác nhau có thể định nghĩa AI khác nhau [1].

Chính phủ Hoa Kỳ chủ trương không vội vàng ban hành luật mới quá sớm, mà tận dụng luật hiện hành và cho phép các cơ quan điều chỉnh trong lĩnh vực của mình diễn giải nguyên tắc AI tương ứng (“Ủy ban Thương mại Liên bang (FTC) đã tuyên bố rằng luật hiện hành (như Section 5, FTC Act) đủ thẩm quyền để xử lý hành vi lừa dối hoặc phân biệt khi sử dụng AI, trong khi Ủy ban Cơ hội việc làm bình đẳng (EEOC) khẳng định sẽ giám sát việc ứng dụng AI trong tuyển dụng nhằm ngăn ngừa thiên vị”) [13], [14].

Chính sách và nguyên tắc: Tháng 10/2022, Nhà Trắng công bố Khuôn khổ “Tuyên ngôn Quyền AI” (Blueprint for an AI Bill of Rights) nêu 5 nguyên tắc bảo vệ người dân trước hệ thống AI (an toàn, không phân biệt, bảo vệ dữ liệu riêng tư, minh bạch - giải thích được, và có lựa chọn thay thế do con người kiểm soát) [15].

Tuy đây chỉ là hướng dẫn không ràng buộc pháp lý, nó thể hiện ưu tiên của Hoa Kỳ về AI tin cậy và nhân quyền.

Chiến lược thực thi: Tháng 10/2023, Tổng thống Joe Biden ký Sắc lệnh hành pháp 14110 về AI an toàn, bảo mật và dáng tin cậy, văn bản điều hành toàn diện nhất của Hoa Kỳ về AI [2]. Sắc lệnh này đề ra các mục tiêu chính sách quốc gia về AI, yêu cầu các cơ quan liên bang hành động để:

- Thúc đẩy cạnh tranh và đổi mới trong ngành AI, duy trì vị thế dẫn đầu của Hoa Kỳ [2].

- Bảo vệ quyền công dân, quyền lao động, quyền riêng tư người tiêu dùng trước các nguy cơ từ AI [2].

- Đảm bảo hệ thống AI do chính phủ mua sắm phải tin cậy, không thiên lệch.

- Phát triển hệ thống gắn watermark (dấu hiệu) cho nội dung AI tạo ra, ngăn chặn đánh cắp sở hữu trí tuệ từ mô hình AI tạo sinh (generative AI) [2].

Bổ nhiệm giám đốc AI tại các cơ quan lớn để giám sát việc triển khai AI [2].

Diễn biến gần đây (2023 - 2025): Sắc lệnh 14110 của Tổng thống Joe Biden đặt nền móng quản trị AI liên bang nhưng đã bị chính quyền kế nhiệm thu hồi vào tháng 1/2025 [2].

Chính quyền mới (2025) theo đuổi cách tiếp cận giảm bớt điều tiết để thúc đẩy sáng tạo AI, thể hiện qua Sắc lệnh “Gỡ bỏ rào cản đối với sự dẫn đầu của Hoa Kỳ về AI” (1/2025) nhằm loại bỏ một số chính sách AI trước đó và nới lỏng giám sát [2].

Mặc dù chưa có luật liên bang, Quốc hội Hoa Kỳ đang thảo luận nhiều dự luật về AI, và một số bang (California, New York, Illinois,...) đã ban hành luật riêng về quyền riêng tư, chống phân biệt thuật toán hoặc quản lý công cụ quyết định tự động.

Yêu cầu minh bạch và an toàn: Hiện nay, các cơ quan như FTC cảnh báo sẽ xử lý các công ty sử dụng AI gây lừa dối hoặc phân biệt đối xử theo luật bảo vệ người tiêu dùng hiện có.

Tháng 7/2023, Nhà Trắng công bố thỏa thuận tự nguyện với 7 công ty AI hàng đầu (Amazon, Anthropic, Google, Inflection, Meta, Microsoft, OpenAI) về an toàn, kiểm thử nội bộ và gắn nhãn nội dung AI” [16].

Sắc lệnh 14110 (2023) yêu cầu phát triển tiêu chuẩn kỹ thuật đánh dấu nội dung AI tạo sinh trên toàn quốc [2]. Năm 2023, Viện Tiêu chuẩn và Công nghệ Quốc gia (NIST) ban hành Khung quản lý rủi ro AI (AI RMF 1.0) nhằm hướng dẫn DN xác định, giảm thiểu rủi ro AI, nhấn mạnh tính an toàn, minh bạch, trách nhiệm. [18]

Trách nhiệm giải trình: Chưa có chế độ trách nhiệm pháp lý mới riêng cho AI, nhưng các công ty có thể bị xử phạt nếu AI của họ vi phạm luật hiện hành (ví dụ: vi phạm quyền riêng tư có thể bị phạt theo Đạo luật GDPR của bang California, hay AI tuyển dụng vi phạm luật phân biệt sẽ bị EEOC xử lý).

Chính quyền cựu Tổng thống Biden từng yêu cầu Văn phòng Chính sách và Khoa học công nghệ (OSTP) và Bộ Thương mại nghiên cứu các khung trách nhiệm pháp lý cho AI, bao gồm việc xem xét trách nhiệm của nhà phát triển khi hệ thống AI gây thiệt hại, nhưng chưa có dự luật chính thức được thông qua” [17].

AI tạo sinh (Generative AI): Hoa Kỳ chú trọng cả tiềm năng và rủi ro của AI tạo sinh.

Sắc lệnh 14110 (2023) yêu cầu các nhà phát triển mô hình AI tiên tiến phải tiến hành đánh giá an toàn trước khi phát hành và chia sẻ kết quả thử nghiệm mức độ nguy hiểm với chính phủ (đặc biệt với mô hình có năng lực vượt ngưỡng nhất định) [2].

Đồng thời, chính phủ khuyến khích phát triển công nghệ kiểm chứng, gắn nhãn nội dung do AI tạo ra nhằm chống tin giả và bảo vệ bản quyền [3]. Tuy nhiên, chưa có quy định bắt buộc dán nhãn trên toàn liên bang và các động thái hiện nay chủ yếu mang tính khuyến nghị và tự nguyện.

Chế tài xử phạt: Do chưa có luật AI chung, không có mức phạt riêng cho AI. Mọi chế tài được áp dụng gián tiếp qua luật sẵn có.

Ví dụ: FTC có thể phạt DN vi phạm luật quảng cáo lừa dối nếu AI bị dùng để tung tin sai lệch. Bộ Tư pháp có thể truy tố nếu AI bị lạm dụng gây hành vi phạm pháp. Trong tương lai, nếu Quốc hội ban hành luật AI, có thể sẽ đề ra các mức phạt và nghĩa vụ cụ thể hơn.

Tóm lại, Hoa Kỳ hiện áp dụng cách tiếp cận linh hoạt với AI: Sử dụng khung pháp luật hiện hữu, ban hành hướng dẫn đạo đức và sắc lệnh hành pháp để định hướng thay vì một đạo luật mới [1].

Trọng tâm là thúc đẩy đổi mới AI để giữ vai trò dẫn đầu, đồng thời dùng luật hiện hành (về bảo vệ người tiêu dùng, chống kỳ thị, an toàn sản phẩm…) để xử lý các hành vi gây hại [1]. Các nguyên tắc như minh bạch, công bằng, bảo vệ quyền riêng tư được chính phủ đề cao, nhưng việc thực thi chủ yếu dựa vào cam kết tự nguyện và giám sát từ các cơ quan có sẵn hơn là quy định cứng rắn.

Liên minh Châu Âu (EU)

Liên minh Châu Âu là khu vực tiên phong ban hành luật toàn diện đầu tiên trên thế giới về AI là Đạo luật AI của EU (EU Artificial Intelligence Act), được Nghị viện Châu Âu thông qua ngày 13/3/2024 và có hiệu lực 1/8/2024 [3], [21].

Luật này thiết lập khuôn khổ quản lý AI dựa trên phân loại rủi ro, với mục tiêu đảm bảo AI an toàn, minh bạch, truy xuất, không phân biệt đối xử và thân thiện với môi trường [3], đồng thời tôn trọng quyền cơ bản của con người.

Một số nội dung nổi bật của Đạo luật:

Định nghĩa AI: EU sử dụng định nghĩa trung lập công nghệ, “bám” Tổ chức Hợp tác và Phát triển kinh tế (OECD): “AI là hệ thống dựa trên máy, được thiết kế vận hành với các mức tự chủ khác nhau, có thể thể hiện tính thích nghi sau khi triển khai, và suy luận từ đầu vào để tạo ra đầu ra (dự đoán, nội dung, khuyến nghị, quyết định) có thể ảnh hưởng môi trường vật lý/ảo” [24], [21]".

Mục tiêu là có một định nghĩa thống nhất, linh hoạt cho cả hiện tại và tương lai [3]. Nghị viện Châu Âu nhấn mạnh cần định nghĩa AI sao cho công nghệ trung lập để áp dụng cho cả hệ thống AI tương lai [3].

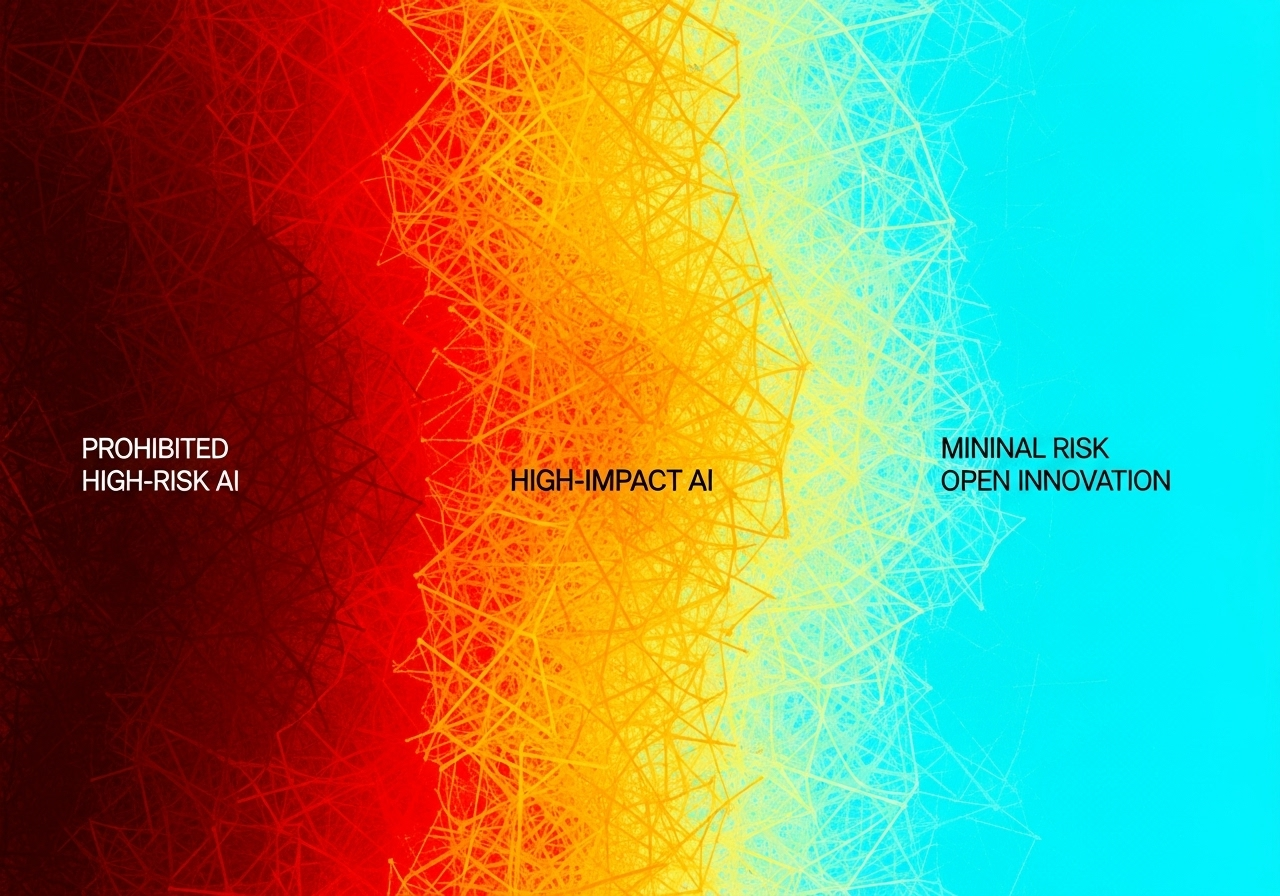

Phân loại rủi ro: Đạo luật AI phân loại hệ thống AI theo 4 mức độ rủi ro [3], [4]:

Rủi ro không thể chấp nhận (Unacceptable risk):

Cấm hoàn toàn, bao gồm các ứng dụng AI được coi là đe dọa nghiêm trọng đến an toàn, quyền con người như:

- Hệ thống “điểm tín nhiệm xã hội” (social scoring) đánh giá công dân [3];

- AI thao túng hành vi con người hoặc nhóm dễ tổn thương (trẻ em, người khuyết tật) gây hại [3];

- Nhận dạng sinh trắc học thời gian thực ở nơi công cộng bị cấm theo nguyên tắc, ngoại trừ một số trường hợp rất hẹp cho cơ quan thực thi pháp luật (ví dụ: ngăn chặn khủng bố, tìm người mất tích), phải có phê chuẩn tư pháp và bảo đảm quyền [23], [25];

- Công cụ suy luận về cảm xúc con người trong bối cảnh nhạy cảm (trừ mục đích y tế/an ninh) [4];

- AI dự đoán khả năng phạm tội của cá nhân dựa trên hồ sơ/xu hướng (trừ hỗ trợ cơ quan pháp luật với dữ liệu khách quan) [4].

Một số ngoại lệ hẹp cho công nghệ nhận dạng khuôn mặt thời gian thực được phép trong trường hợp ngăn chặn khủng bố, tìm trẻ em mất tích hoặc tội phạm nghiêm trọng, nhưng phải có phê chuẩn tư pháp và đánh giá tác động nhân quyền trước khi triển khai [4].

Rủi ro cao (High risk): Quy định chặt chẽ.

Áp dụng cho hệ thống AI có ảnh hưởng xấu tới an toàn hoặc quyền cơ bản. Luật liệt kê 2 nhóm AI “rủi ro cao” [3]:

AI là thành phần an toàn của sản phẩm thuộc lĩnh vực đã quản lý an toàn (ví dụ: phương tiện tự hành, thiết bị y tế, thang máy, đồ chơi an toàn…) [3]. Những hệ thống này sẽ chịu cả luật sản phẩm lẫn quy định AI.

AI được sử dụng trong 8 lĩnh vực nhạy cảm phải đăng ký vào cơ sở dữ liệu (CSDL) EU [3], gồm: vận hành hạ tầng thiết yếu; giáo dục và đào tạo nghề (ví dụ AI chấm điểm thi); tuyển dụng và quản lý lao động; dịch vụ thiết yếu tư nhân và công (phân bổ phúc lợi xã hội, tín dụng); thực thi pháp luật; quản lý nhập cư, tị nạn, kiểm soát biên giới; hỗ trợ tư pháp; và một số lĩnh vực khác tác động đáng kể đến an toàn, quyền con người.

Yêu cầu với AI rủi ro cao: Phải đánh giá phù hợp (conformity assessment) trước khi đưa ra thị trường và suốt vòng đời [3].

Nhà cung cấp phải đảm bảo hệ thống đáp ứng hàng loạt tiêu chuẩn: quản trị rủi ro, chất lượng dữ liệu huấn luyện (đảm bảo chính xác, không thiên lệch), tài liệu kỹ thuật chi tiết, ghi log hoạt động, tính minh bạch với người dùng, kiểm soát của con người, an toàn an ninh mạng và kế hoạch giám sát hậu kiểm [5].

Người dùng (tổ chức triển khai) AI rủi ro cao cũng có nghĩa vụ vận hành đúng hướng dẫn, giám sát đầu ra và báo cáo sự cố. Công dân có quyền khiếu nại AI rủi ro cao với cơ quan quản lý nếu thấy bị ảnh hưởng [3].

Rủi ro hạn chế (limited risk): Nghĩa vụ minh bạch. Nhóm này không bị cấm hay đánh giá trước, nhưng phải tuân thủ một số yêu cầu công khai minh bạch nhất định [4].

Ví dụ: chatbot phải thông báo cho người dùng biết họ đang tương tác với AI, không phải con người [4]; nội dung tạo bằng AI (ảnh, video deepfake) phải được gắn nhãn để người xem nhận biết [3].

Các hệ thống AI tương tác đơn giản (như bộ lọc spam, game AI) nằm trong nhóm này và chỉ cần đáp ứng yêu cầu minh bạch cơ bản.

Rủi ro tối thiểu (Minimal or low risk): Không chịu quy định đặc thù. Đây là đa số hệ thống AI (chiếm phần lớn ứng dụng AI thương mại hiện nay) được tự do phát triển theo luật chung, không có nghĩa vụ bổ sung theo Đạo luật AI [4].

Ví dụ: AI trong game, phần mềm email lọc spam… (Lưu ý: Điều này có thể thay đổi khi AI tạo sinh trở nên phổ biến hơn) [4].

Nguyên tắc đạo đức và an toàn: EU theo đuổi cách tiếp cận “AI lấy con người làm trung tâm” (human-centric AI). Nghị viện châu Âu yêu cầu mọi hệ thống AI tại EU phải an toàn, minh bạch, có thể truy vết, không phân biệt đối xử và thân thiện môi trường [3]. Đặc biệt, phải có sự can thiệp của con người ở những điểm quyết định quan trọng nhằm tránh hệ quả tự động gây hại [3].

EU cũng nhấn mạnh yếu tố bền vững: AI nên được thiết kế tiết kiệm năng lượng, hỗ trợ các mục tiêu xanh của EU.

Minh bạch và ghi nhãn: Ngoài các yêu cầu minh bạch cho AI rủi ro hạn chế nêu trên, Đạo luật AI còn bắt buộc:

Hệ thống AI sinh trắc học nhận dạng cảm xúc hoặc phân loại đặc điểm nhạy cảm (sắc tộc, giới tính, tín ngưỡng…) phải thông báo cho người bị thu thập dữ liệu biết và chỉ được dùng trong giới hạn cho phép [4].

Nội dung do AI tạo ra (deepfake, ảnh, video, âm thanh tổng hợp): phải gắn nhãn rõ ràng để người xem biết đó không phải nội dung thật [3]. Ví dụ, video deepfake phải chèn thông báo hoặc watermark.

Chatbot/AI tương tác với con người: phải tiết lộ cho người dùng rằng họ đang tương tác với AI, trừ khi điều này rõ ràng (ví dụ chatbot tổng đài phải giới thiệu nó là trợ lý ảo) [4].

AI generative (mô hình tạo sinh): không bị xếp vào rủi ro cao chỉ vì là generative AI, nhưng phải tuân thủ nghĩa vụ minh bạch đặc thù:

(i) Tiết lộ nội dung do AI tạo ra (như trên);

(ii) Thiết kế để ngăn nội dung vi phạm pháp luật (ví dụ chặn tạo thông tin kích động thù địch);

(iii) Công bố tóm tắt dữ liệu có bản quyền dùng để huấn luyện mô hình [3].

Quy định này nhằm bảo vệ quyền tác giả và cho phép kiểm toán tính công bằng của dữ liệu.

AI mục đích chung có tác động lớn (GPAI - General Purpose AI): EU bổ sung riêng điều khoản cho mô hình AI đa dụng như GPT-4. Nhà cung cấp mô hình nền tảng phải cung cấp tài liệu kỹ thuật và hướng dẫn sử dụng, tuân thủ luật bản quyền và công bố thông tin về dữ liệu huấn luyện [4].

Nếu mô hình nguồn mở, chỉ cần tuân thủ bản quyền và công bố dữ liệu huấn luyện, trừ khi mô hình gây rủi ro hệ thống lớn [4]. Mô hình GPAI có nguy cơ hệ thống (ví dụ GPT-4 và các AI tổng quát rất mạnh) có thể bị yêu cầu thực hiện đánh giá an toàn nghiêm ngặt hơn, kiểm thử đối kháng, báo cáo sự cố cho Ủy ban Châu Âu (EC) và đáp ứng tiêu chuẩn an ninh mạng [3], [4].

Trách nhiệm và chế tài: Đạo luật AI áp đặt phần lớn nghĩa vụ lên “nhà cung cấp” (provider) - tức tổ chức/pháp nhân phát triển hệ thống AI và đưa ra thị trường EU [4]. Nhà cung cấp ngoài EU cũng chịu luật nếu hệ thống của họ được sử dụng tại EU [4].

“Người sử dụng chuyên nghiệp” (user) - tổ chức ứng dụng AI vào hoạt động kinh doanh - cũng có trách nhiệm vận hành an toàn và giám sát AI, nhưng nhẹ hơn nhà cung cấp [4]. Vi phạm luật AI sẽ bị phạt nặng: mức phạt tối đa lên tới 35 triệu euro hoặc 7% doanh thu toàn cầu (lấy mức cao hơn); các vi phạm nghĩa vụ khác 15 triệu euro hoặc 3%; cung cấp thông tin sai/misleading có khung thấp hơn” [22], [26], [5].

Cụ thể, vi phạm lệnh cấm (AI rủi ro không chấp nhận) hoặc yêu cầu an toàn dữ liệu có thể phạt đến 7% doanh thu; vi phạm nghĩa vụ khác như minh bạch có thể phạt 4% doanh thu… [5].

Cơ chế thực thi: mỗi quốc gia EU sẽ chỉ định cơ quan giám sát AI quốc gia. Một Văn phòng AI châu Âu (EU AI Office) cũng được lập để hỗ trợ thực thi thống nhất, gồm đại diện các nước, trực tiếp giám sát GPAI, còn các cơ quan quốc gia giám sát phần còn lại; các nước phải chỉ định cơ quan giám sát và thiết lập regulatory sandbox.” [25], [27], [3]. Người dân có quyền khiếu nại hoặc khởi kiện nếu bị thiệt hại do vi phạm luật AI.

AI tạo sinh (Generative AI): Như đã đề cập, EU không coi mọi AI tạo sinh là rủi ro cao tự động, nhưng đã bổ sung điều khoản đáp ứng xu hướng công nghệ.

Tháng 6/2023, Nghị viện Châu Âu chỉnh sửa dự luật để siết mô hình nền tảng (foundation models): yêu cầu hệ thống generative AI như ChatGPT phải đăng ký minh bạch, công bố tóm tắt dữ liệu huấn luyện (đặc biệt dữ liệu có bản quyền) và triển khai biện pháp ngăn chặn nội dung bất hợp pháp [3].

Đồng thời, EU đang phát triển tiêu chuẩn kỹ thuật và Bộ quy tắc ứng xử tự nguyện cho AI tạo sinh trong giai đoạn chuyển tiếp (trước khi luật có hiệu lực hoàn toàn). Những mô hình tạo sinh có tầm ảnh hưởng cao hoặc rủi ro hệ thống có thể phải trải qua đánh giá kỹ lưỡng và báo cáo sự cố nghiêm trọng cho cơ quan EU [3].

Chiến lược thực thi và lộ trình áp dụng: Đạo luật AI đã được phê chuẩn năm 2024 nhưng chưa áp dụng ngay lập tức.

Các quy định sẽ có hiệu lực sau khoảng thời gian chuyển tiếp để các bên thích ứng [3]:

Lệnh cấm ứng dụng AI rủi ro không chấp nhận bắt đầu hiệu lực từ 2/2/2025 (tức các hệ thống như chấm điểm xã hội (social scoring) bị cấm ngay) [3].

Các bộ quy tắc hướng dẫn và ứng xử sẽ được ban hành trong vòng 9 tháng sau khi luật có hiệu lực.

Yêu cầu minh bạch đối với AI mục đích chung (GPAI) có hiệu lực sau 12 tháng từ ngày hiệu lực luật (khoảng 2025- 2026) [3].

Nghĩa vụ tuân thủ với hệ thống AI rủi ro cao có hiệu lực muộn hơn, 36 tháng sau ngày hiệu lực luật, tức khoảng 2026 - 2027 [3], nhằm cho doanh nghiệp (DN) thêm thời gian chuẩn bị.

EU cũng thành lập Nhóm công tác Nghị viện về AI để giám sát quá trình triển khai luật, đảm bảo luật thực sự thúc đẩy phát triển số và không kìm hãm đổi mới [3]. Các “hộp cát” (sandbox) thử nghiệm AI sẽ được thiết lập ở mỗi nước để DN (đặc biệt startup, DN nhỏ và vừa - SME) thử nghiệm AI trong môi trường kiểm soát trước khi ra mắt [3]. Điều này giúp duy trì đổi mới trong khi vẫn quản lý được rủi ro.

Tóm lại, EU AI Act là khung pháp lý toàn diện và nghiêm ngặt, đặt ra tiêu chuẩn toàn cầu về AI đáng tin cậy. Luật nhấn mạnh quản lý theo rủi ro: cấm những ứng dụng AI nguy hại nhất, siết chặt lĩnh vực nhạy cảm, nhưng không can thiệp quá mức vào các ứng dụng AI thông thường [4].

Đồng thời, EU yêu cầu minh bạch và gắn trách nhiệm cho bên phát triển lẫn triển khai AI, với cơ chế phạt nặng để răn đe [5]. Mô hình quản lý này phản ánh giá trị cốt lõi của châu Âu về nhân quyền và an toàn, và có thể trở thành hình mẫu cho nhiều quốc gia khác khi xây dựng luật AI.

Trung Quốc

Trung Quốc tiếp cận quản lý AI theo hướng ban hành các quy định chuyên biệt tập trung vào từng rủi ro công nghệ mới, hơn là một đạo luật thống nhất. Trong vài năm qua, Trung Quốc đã nhanh chóng đưa ra hàng loạt văn bản pháp quy để kiểm soát AI, đặc biệt trong lĩnh vực nội dung thông tin và an ninh quốc gia [1], [6].

Các văn bản pháp lý quan trọng giai đoạn 2021 - 2025

Quy định về thuật toán đề xuất (có hiệu lực từ ngày 1/3/2022)

“Quy định Quản lý dịch vụ thuật toán đề xuất Internet” (Provisions on the Management of Algorithmic Recommendation in Internet Information Services) yêu cầu các hệ thống gợi ý nội dung (như mạng xã hội, video ngắn, thương mại điện tử) phải đăng ký thuật toán với nhà nước, công khai nguyên tắc hoạt động và không được lợi dụng thuật toán để “đi ngược lại đạo đức xã hội, gây nguy hại an ninh quốc gia” hoặc phát tán tin giả [28], [31].

Các dịch vụ có “thuộc tính dư luận” hoặc “khả năng huy động xã hội” phải hoàn tất thủ tục nộp hồ sơ thuật toán (filing) trong vòng 10 ngày làm việc với Cục Quản lý Không gian mạng Trung Quốc (CAC) [28]. Văn bản này nhấn mạnh nguyên tắc rằng thuật toán phải phù hợp với “giá trị xã hội chủ nghĩa cốt lõi” và không gây bất ổn [28], [32].

Quy định về tổng hợp sâu (deep synthesis), (có hiệu lực từ ngày 10/1/2023)

“Quy định quản lý dịch vụ thông tin tổng hợp sâu Internet” (Provisions on the Administration of Deep Synthesis Internet Information Services) điều chỉnh công nghệ tạo nội dung bằng AI như video, âm thanh, ảnh hoặc giọng nói tổng hợp [29].

Văn bản bắt buộc gắn dấu hiệu nhận biết (watermark hoặc nhãn) với nội dung tổng hợp, xác thực danh tính thật của người dùng, và lưu trữ nhật ký hệ thống để phục vụ kiểm tra [29]. Nhà cung cấp phải bảo đảm nội dung tổng hợp không vi phạm pháp luật hoặc xâm phạm quyền chân dung, danh dự của người khác [29].

Quy tắc đạo đức AI thế hệ mới (ban hành tháng 9/2021)

Bộ Khoa học và Công nghệ Trung Quốc ban hành “Quy tắc Đạo đức AI thế hệ mới” xác định 6 nguyên tắc nền tảng: (i) lấy con người làm trung tâm; (ii) an toàn và kiểm soát được; (iii) công bằng và công minh; (iv) bảo vệ quyền riêng tư và an ninh; (v) nâng cao phúc lợi con người; và (vi) tăng cường trách nhiệm xã hội [33].

Dù không có giá trị pháp lý ràng buộc, văn kiện này định hướng các quy định AI sau này theo tinh thần “AI phục vụ xã hội chủ nghĩa (XHCN) và chịu sự giám sát chặt chẽ của Nhà nước” [33].

Biện pháp quản lý dịch vụ AI tạo sinh (có hiệu lực từ ngày 15/8/2023)

Ngày 15/8/2023, Trung Quốc ban hành “Biện pháp quản lý dịch vụ trí tuệ nhân tạo tạo sinh (tạm thời)” (Interim Measures for the Management of Generative Artificial Intelligence Services) p văn bản pháp quy đầu tiên dành riêng cho AI tạo sinh [30], [35].

Theo đó, phạm vi áp dụng là: Mọi tổ chức hoặc cá nhân cung cấp dịch vụ AI tạo sinh (văn bản, hình ảnh, âm thanh, video, hoặc mã) cho công chúng tại Trung Quốc, bao gồm cả nhà cung cấp nước ngoài cung cấp dịch vụ trực tuyến [30].

Đánh giá an ninh và giấy phép: Các dịch vụ có “thuộc tính dư luận” hoặc “khả năng huy động xã hội” phải đăng ký và thực hiện đánh giá an ninh trước khi ra mắt [30], [34]. Tiêu chí này khá mơ hồ nên nhiều công ty chủ động tuân thủ để tránh rủi ro.

Kiểm soát nội dung đầu ra: Nhà cung cấp chịu trách nhiệm pháp lý với nội dung do AI tạo ra; mọi đầu ra phải phù hợp giá trị XHCN và tuân thủ luật pháp (không chứa nội dung bạo lực, khiêu dâm, hoặc kích động chống nhà nước) [30].

Yêu cầu minh bạch: Nội dung do AI tạo ra phải được gắn nhãn rõ ràng hoặc watermark để người dùng biết đó là nội dung giả lập [30].

Bảo vệ dữ liệu và quyền riêng tư: Nhà cung cấp không được thu thập dữ liệu cá nhân không cần thiết và phải tuân thủ Luật Bảo vệ thông tin cá nhân (PIPL), Luật an ninh dữ liệu (DSL) và Luật an ninh mạng (CSL) [30].

Thực thi: Bản cuối không quy định mức phạt riêng, mà quy định xử lý vi phạm theo các luật hiện hành (CSL, DSL, PIPL) [30], [6]. Cơ quan quản lý có thể áp dụng các biện pháp hành chính (phạt tiền, đình chỉ dịch vụ, truy cứu hình sự nếu nghiêm trọng).

Các chính sách và định hướng bổ trợ

Trung Quốc lồng ghép quản trị AI vào nhiều luật hiện hành: Luật An ninh mạng (2017), Luật An ninh Dữ liệu (2021), và Luật Bảo vệ thông tin cá nhân (2021), đồng thời triển khai chương trình “AI Plus” để thúc đẩy ứng dụng AI trong sản xuất và dịch vụ, song luôn đặt trọng tâm vào chủ quyền công nghệ và kiểm soát nhà nước [1], [6].

Nguyên tắc xuyên suốt là mọi hệ thống AI phải tuân thủ giá trị XHCN cốt lõi, bảo đảm an ninh chính trị và ổn định xã hội, dưới sự giám sát của Cục Quản lý Không gian mạng Trung Quốc (CAC) phối hợp cùng các bộ ngành chuyên trách [28], [30].

Tóm lại, Trung Quốc chưa có “luật AI” duy nhất, nhưng đã xây dựng một hệ sinh thái pháp lý bao quanh AI rất nhanh và nghiêm ngặt.

Cách làm là điều chỉnh theo từng công nghệ (thuật toán đề xuất, deep synthesis, generative AI), đặt ra nghĩa vụ cụ thể về đăng ký, kiểm soát nội dung, minh bạch và bảo vệ dữ liệu, gắn với các giá trị chính trị - xã hội đặc thù.

Phương châm của Trung Quốc là phát triển AI trong vòng kiểm soát, phục vụ lợi ích nhà nước và không gây bất ổn xã hội - một mô hình khác biệt với phương Tây, nhấn mạnh kiểm duyệt nội dung và an ninh quốc gia hơn là quyền cá nhân [1], [6], [28] - [30].

Hàn Quốc

Hàn Quốc là quốc gia châu Á đầu tiên ban hành luật tổng thể về AI, với mục tiêu vừa thúc đẩy phát triển AI vừa đảm bảo AI tin cậy.

Đạo luật có tên “Đạo luật Khung về Phát triển trí tuệ nhân tạo và thiết lập nền tảng cho độ tin cậy” “Act on the Development of Artificial Intelligence and the Establishment of a Foundation for Trust (AI Basic Act/AI Framework Act)” [36], [38], [43] (gọi tắt: Đạo luật Cơ bản về AI), được Quốc hội Hàn Quốc thông qua 26/12/2024; Promulgation 21/01/2025; Hiệu lực 22/01/2026.” [7], [37], [38].

Một số đặc điểm chính của luật:

Mục tiêu và phạm vi: Luật đặt nền tảng pháp lý để nâng cao năng lực cạnh tranh quốc gia về AI đồng thời đảm bảo tiêu chuẩn đạo đức và niềm tin công chúng [8].

Hàn Quốc là quốc gia đầu tiên ở khu vực châu Á - Thái Bình Dương (APAC) ban hành luật AI tổng thể [36]; đồng thời thường được mô tả là đạo luật AI tổng thể thứ hai trên thế giới sau EU [41] có khung pháp luật toàn diện về AI [8]. Luật có phạm vi ngoài lãnh thổ: áp dụng cho hoạt động AI có ảnh hưởng đến thị trường hoặc người dùng tại Hàn Quốc, kể cả nếu hệ thống AI được phát triển ở nước ngoài [7], [36].

Thiết chế quản lý: Luật thành lập một “đầu não AI quốc gia” (AI Control Tower) để điều phối chiến lược AI và một Viện An toàn AI để nghiên cứu, kiểm định các hệ thống AI quan trọng [8]. Chính phủ cũng được giao phát triển các sáng kiến R&D, tiêu chuẩn hóa và cơ sở hạ tầng AI: ví dụ xây cụm AI (AI clusters), xây trung tâm dữ liệu AI quốc gia phục vụ phát triển AI [8], và hỗ trợ DN nhỏ và vừa, startup, đào tạo nhân tài AI [8], [37], [38], [39].

Định nghĩa AI và phân loại rủi ro: Đạo luật định nghĩa “trí tuệ nhân tạo” là “hệ thống mô phỏng năng lực trí tuệ của con người như học tập, lý luận, tri giác, phán đoán và hiểu ngôn ngữ” [7].

“Hệ thống AI” là hệ thống tạo kết quả (dự đoán, khuyến nghị, quyết định) với mức độ tự chủ nhất định để đạt mục tiêu nhất định [7]. Đáng chú ý, luật đưa ra khái niệm “AI tác động cao” (high-impact AI) cho những hệ thống “có thể ảnh hưởng đáng kể hoặc gây rủi ro cho tính mạng, an toàn con người hoặc quyền cơ bản” trong các lĩnh vực trọng yếu (năng lượng, y tế, hạt nhân, xử lý dữ liệu sinh trắc, ra quyết định công...) [7].

Hệ thống AI tác động cao sẽ chịu yêu cầu nghiêm ngặt hơn. Khác với EU, Hàn Quốc không có danh mục “AI bị cấm” cụ thể - luật không quy định cấm hẳn ứng dụng nào, mà tập trung vào quản lý mức cao nhất là nhóm “tác động cao” [7].

Nghĩa vụ và nguyên tắc: Đạo luật áp dụng cho cả “bên phát triển AI” và “bên triển khai sử dụng AI”, gọi chung là “DN AI” [7]. Một số nghĩa vụ chính gồm:

Với AI tác động cao: DN phải thực hiện đánh giá rủi ro AI định kỳ, triển khai các biện pháp an toàn và cơ chế giám sát con người, đảm bảo hệ thống vận hành tin cậy [8]. Chính phủ sẽ ban hành tiêu chuẩn cụ thể về đánh giá tác động và an toàn cho AI trong các lĩnh vực này.

Minh bạch và giải thích: Tất cả DN AI, bất kể phát triển hay sử dụng, đều phải đáp ứng nghĩa vụ minh bạch. Đặc biệt, các sản phẩm/dịch vụ AI tạo sinh phải có dán nhãn cho nội dung do AI tạo ra để người dùng nhận biết [7]. Người dùng có quyền được thông báo khi quyết định/dịch vụ do AI cung cấp.

Quyền lợi người dùng: Luật yêu cầu DN cung cấp kênh giải quyết khiếu nại liên quan đến AI, cho phép người dùng phản hồi khi cho rằng quyết định AI sai hoặc xâm phạm quyền.

Bảo vệ dữ liệu: Phải tuân thủ luật bảo vệ thông tin cá nhân hiện hành (PIPA của Hàn Quốc). Có thể sẽ có hướng dẫn cụ thể phối hợp giữa Bộ Khoa học và CNTT (MSIT) và Ủy ban Bảo vệ Thông tin cá nhân (PIPC) để đảm bảo AI xử lý dữ liệu riêng tư đúng luật [7].

Quản lý AI tạo sinh: Luật Hàn Quốc đặc biệt đề cập AI tạo sinh và đặt ra yêu cầu minh bạch bổ sung.

Cụ thể, nội dung (văn bản, hình ảnh, âm thanh...) do AI tạo ra phải được ghi rõ là do AI tạo [7]. Đây gần tương tự quy định minh bạch của EU, nhằm chống việc dùng deepfake, nội dung giả mạo. Ngoài ra, cơ quan quản lý có thể ban hành tiêu chuẩn kỹ thuật về độ an toàn của mô hình AI tạo sinh (như tránh phát sinh nội dung độc hại).

Chế tài xử phạt: Khác với EU phạt doanh thu, Hàn Quốc chọn cách xử phạt hành chính mức vừa phải. Mức phạt tối đa theo luật chỉ khoảng 30 triệu won (tương đương 21.000 USD) [7], [36] cho vi phạm nghĩa vụ. Mức phạt này thấp hơn nhiều so với EU (có thể hàng chục triệu euro) [7], thể hiện quan điểm “chế tài nhẹ để không cản trở đổi mới”.

Thay vì phạt nặng, Hàn Quốc chú trọng yêu cầu khắc phục: nếu DN không tuân thủ, cơ quan có thể yêu cầu sửa đổi, tạm ngừng hệ thống AI cho đến khi đáp ứng tiêu chuẩn. Bên cạnh đó, luật có ngoại lệ miễn trừ cho AI quốc phòng, an ninh, các ứng dụng AI quân sự không chịu sự điều chỉnh của đạo luật này [36].

Thúc đẩy đổi mới và hợp tác: Luật Hàn Quốc cân bằng giữa quản lý và phát triển. Ngoài các nghĩa vụ, luật còn cam kết hỗ trợ mạnh mẽ: chính phủ sẽ đầu tư xây dựng hạ tầng dữ liệu huấn luyện (bộ dữ liệu (data set) mở, trung tâm tính toán hiệu năng cao), hỗ trợ DN thử nghiệm AI trong thực tế, tài trợ nghiên cứu tiêu chuẩn AI quốc tế cho DN Hàn [7]. Hàn Quốc cũng sẽ hợp tác quốc tế (với OECD, EU…) để điều phối chính sách AI, đảm bảo DN Hàn Quốc đáp ứng yêu cầu xuất khẩu.

Tóm lại, Hàn Quốc đã xây dựng một đạo luật AI toàn diện với cách tiếp cận “phân lớp theo mức độ tác động” tương tự EU nhưng linh hoạt hơn. Luật tập trung giám sát AI tác động cao (trong lĩnh vực thiết yếu ảnh hưởng an toàn và quyền con người) [7], yêu cầu minh bạch (đặc biệt với AI tạo sinh) [7], nhưng không cấm tuyệt đối ứng dụng nào và chế tài cũng nhẹ hơn EU [7].

Đồng thời, Hàn Quốc coi luật này như đòn bẩy thúc đẩy hệ sinh thái AI nội địa - từ đầu tư hạ tầng, hỗ trợ DN đến xây dựng lòng tin người dân vào AI. Đây được xem là bước đi cân bằng giữa đổi mới và quản lý, phù hợp với môi trường công nghệ năng động của Hàn Quốc [36], [38], [43].

Singapore

Singapore tiếp cận quản trị AI theo hướng “linh hoạt, nhanh nhạy và dựa trên nguyên tắc tự nguyện”, áp dụng các khung hướng dẫn đạo đức mềm thay vì quy định pháp lý ràng buộc [9], [44].

Tính đến năm 2025, Singapore chưa ban hành luật chuyên biệt điều chỉnh AI [9], [44].

Thay vào đó, chính phủ sử dụng các luật hiện hành (như Luật Bảo vệ dữ liệu cá nhân - PDPA, Luật Cạnh tranh và Tiêu dùng, Luật An ninh mạng) kết hợp với bộ hướng dẫn tự nguyện để quản lý rủi ro và thúc đẩy đổi mới [9], [45]. Cách tiếp cận này được Chính phủ mô tả là “light-touch but principled” - mềm dẻo nhưng có định hướng rõ ràng [46].

Không có luật AI riêng biệt

Singapore chưa có đạo luật riêng cho AI; các vấn đề phát sinh từ AI được điều chỉnh qua các luật hiện hành [9], [44].

Ví dụ: nếu một hệ thống AI vi phạm quyền riêng tư, Ủy ban Bảo vệ dữ liệu cá nhân (PDPC) có thể xử lý theo Luật bảo vệ dữ liệu cá nhân (Personal Data Protection Act - PDPA) [45].

Theo White & Case (2025), “there are no specific laws, statutory rules, or regulations in Singapore that directly regulate AI.” [44].

Chính phủ chủ trương không luật hóa sớm, để tránh cản trở sáng tạo, đồng thời giữ khả năng can thiệp nhanh khi cần thiết.

Khung quản trị AI mẫu (Model AI Governance Framework)

Singapore là quốc gia đầu tiên ở châu Á công bố khung quản trị AI tự nguyện dành cho DN: Phiên bản 1.0 được ra mắt tháng 1/2019; Phiên bản 2.0 công bố tháng 1/2020 [45], [47].

Khung này do PDPC (thuộc Bộ Truyền thông và Thông tin) phát triển, gồm 4 nguyên tắc cốt lõi: (1) Minh bạch & Giải thích được (Transparency & Explainability); (2) Công bằng (Fairness); (3) Trách nhiệm giải trình (Accountability); (4) Can thiệp của con người (Human-in-the-loop Governance)

Doanh nghiệp được hướng dẫn cách tích hợp các nguyên tắc này vào thiết kế, vận hành và đánh giá tác động của hệ thống AI. Khung này không mang tính cưỡng chế, mà nhằm xây dựng lòng tin và nâng cao năng lực quản trị AI trong khu vực tư nhân [47].

Khung dành riêng cho AI tạo sinh (Generative AI Framework, 2024)

Tháng 5/2024, Singapore công bố “Model AI Governance Framework for Generative AI” - phụ lục mở rộng cho khung 2019 [48]. Tài liệu này tập trung vào đặc thù của AI tạo sinh (GenAI), với các hướng dẫn tự nguyện cho tổ chức và nhà phát triển:

Minh bạch đầu ra: Khuyến nghị đánh dấu hoặc gắn nhãn nội dung do AI tạo [48].

Giảm thiên kiến: Đánh giá và giảm bias trong dữ liệu và mô hình.

Kiểm soát đầu ra nguy hiểm: Thiết lập bộ lọc ngăn nội dung kích động, bạo lực hoặc sai lệch.

Bảo vệ quyền sở hữu trí tuệ: Xem xét dữ liệu có bản quyền dùng để huấn luyện và sinh đầu ra.

Giám sát con người: Yêu cầu có thể can thiệp khi AI tạo kết quả ảnh hưởng nghiêm trọng [48].

Khung này vẫn mang tính khuyến nghị, không có chế tài bắt buộc, và được xem là công cụ mềm giúp DN chủ động quản trị rủi ro từ GenAI [48], [49].

Cơ chế thể chế và công cụ hỗ trợ

Singapore triển khai nhiều sáng kiến quản trị và thử nghiệm AI ở tầm quốc gia:

Chiến lược AI Quốc gia (National AI Strategy 1.0 - 2019, 2.0 - 2023) định hướng phát triển AI vì lợi ích công và bền vững [50].

Văn phòng AI Quốc gia (Office for AI) thuộc Văn phòng Thủ tướng điều phối chính sách AI quốc gia [50].

AI Verify (2022): Bộ công cụ kiểm thử tự nguyện giúp DN đánh giá hệ thống AI theo 11 nguyên tắc đạo đức (an toàn, minh bạch, công bằng, bảo mật…) [51].

AI Verify được phát triển bởi IMDA và PDPC, nay được điều hành bởi AI Verify Foundation (tổ chức phi lợi nhuận công - 2023) để chuẩn hóa các quy tắc kiểm định AI trên toàn cầu [51].

Global AI Assurance Pilot (2025): Singapore hợp tác với Anh và OECD để thử nghiệm hệ thống đánh giá tin cậy AI xuyên quốc gia [52].

Luật hiện hành liên quan AI

Dù chưa có luật AI riêng, Singapore áp dụng nhiều luật hiện có để điều chỉnh hành vi liên quan AI:

Luật bảo vệ dữ liệu cá nhân (PDPA): điều chỉnh việc thu thập, sử dụng, chia sẻ dữ liệu cho huấn luyện AI [45].

Luật Cạnh tranh và Tiêu dùng (CCCS): xử lý hành vi AI gây lừa dối, không công bằng [45].

Luật An ninh mạng: bảo vệ hạ tầng kỹ thuật khỏi AI độc hại.

Ngoài ra, khu vực công có Bộ Quy tắc AI cho Chính phủ, yêu cầu đánh giá rủi ro trước khi triển khai AI trong các dịch vụ công [50].

Triết lý “quản lý nhẹ tay”

Singapore mô tả chiến lược của nước này là “light-touch but high-trust”, không áp luật cứng sớm, nhưng duy trì ranh giới an toàn [46].

Singapore tin rằng cách tiếp cận mềm dẻo, có thể điều chỉnh nhanh sẽ giúp quốc gia nhỏ này giữ vai trò trung tâm thử nghiệm AI toàn cầu, thu hút đầu tư và đổi mới, đồng thời bảo đảm an toàn và đạo đức công nghệ [9], [45].

Tóm lại, Singapore chọn điều tiết AI dựa trên đạo đức, hướng dẫn tự nguyện và công cụ kiểm chứng, thay vì luật bắt buộc.

Khung quản trị AI (Model AI Governance Framework) và xác thực AI (AI Verify) trở thành trụ cột giúp DN và cơ quan nhà nước quản lý AI có trách nhiệm, trong khi luật chung (như PDPA) vẫn đảm bảo nền tảng pháp lý.

Cách tiếp cận này phản ánh triết lý “nhẹ tay nhưng định hướng rõ ràng”, phù hợp với môi trường công nghệ năng động và định vị Singapore là trung tâm phát triển AI đáng tin cậy của châu Á [9], [44] - [52].

Malaysia

Malaysia hiện chưa có luật chuyên biệt về AI, nhưng đã triển khai cách tiếp cận “hướng dẫn trước, luật hóa sau”: dùng khung tự nguyện ở cấp quốc gia kết hợp điều chỉnh bằng luật hiện hành (như PDPA) để quản trị rủi ro AI và chuẩn bị năng lực cho khung ràng buộc trong tương lai [53], [56], [57].

Chiến lược và lộ trình

Malaysia ban hành lộ trình AI quốc gia (National Artificial Intelligence Roadmap - AI-RMAP) 2021 - 2025 làm định hướng tổng thể phát triển AI phục vụ kinh tế số và phúc lợi xã hội; trụ cột có quản trị/đạo đức (governance/ethics) và chuẩn bị khung hướng dẫn trước khi luật hóa [59], [58].

Hướng dẫn quốc gia về quản trị và đạo đức AI (2024)

Ngày 20/09/2024, Bộ Khoa học, Công nghệ và Đổi mới sáng tạo (MOSTI) công bố khung hướng dẫn quốc gia về quản trị AI và đạo đức (National Guidelines on AI Governance & Ethics) - khung tự nguyện, không ràng buộc pháp lý, nhằm hướng dẫn nhà phát triển/nhà cung cấp, nhà hoạch định chính sách, người dùng thực hành, ứng dụng AI có trách nhiệm [53], [54], [55].

Tài liệu xoay quanh 7 nguyên tắc thường thấy trong chuẩn mực quốc tế (công bằng; an toàn/bảo mật/kiểm soát; quyền riêng tư; tính bao trùm; minh bạch/giải thích được; trách nhiệm giải trình; lợi ích cho con người) và liên hệ OECD/UNESCO/EU để bảo đảm khả năng tương thích [53], [55].

Thể chế triển khai

Malaysia thành lập Văn phòng AI quốc gia (National AI Office - NAIO) để điều phối chính sách/điều tiết AI, xây quy tắc đạo đức, khung quy định và kế hoạch công nghệ 5 năm đến 2030 ra mắt 12/12/2024 [56], [57]. Một số hoạt động phối hợp đa bên cũng được báo chí và cổng NAIO cập nhật [56], [57].

Cập nhật nền tảng pháp lý PDPA

Để nâng chuẩn bảo vệ dữ liệu làm nền cho AI tin cậy, Malaysia thông qua Luật bảo vệ dữ liệu cá nhân sửa đổi (Personal Data Protection (Amendment) Act) năm 2024, triển khai từ 2025, với các điểm chính:

Thứ nhất, tăng mức phạt vi phạm nguyên tắc bảo vệ dữ liệu lên tối đa 1,000,000 ringgit và/hoặc 3 năm tù;

Thứ hai, bắt buộc chỉ định cán bộ bảo vệ dữ liệu (DPO); bắt buộc thông báo vi phạm dữ liệu;

Thứ ba, mở rộng dữ liệu cá nhân nhạy cảm (sensitive personal data) để bao gồm dữ liệu sinh trắc;

Thứ tư, bỏ dánh sách trắng (whitelist) chuyển dữ liệu quốc tế, chuyển sang đánh giá tương đương/bảo vệ tương đương;

Thứ năm, làm rõ vai trò quản lý/xử lý (data controller/processor); bổ sung quyền chuyển dữ liệu (data portability) [60], [61].

Những thay đổi này giúp PDPA tiệm cận chuẩn quốc tế và là bệ đỡ pháp lý khi áp dụng AI vào xử lý dữ liệu cá nhân [60], [61].

Malaysia định vị hướng dẫn (guidelines) như bước tiên tiến: khuyến khích ngành tuân thủ đạo đức, thử nghiệm khung đánh giá có kiểm soát (sandbox), và đánh giá tác động, trong khi tiếp tục nghiên cứu mô hình luật hóa (tham khảo EU, Hàn Quốc) [55]. Chưa có dự luật AI công bố; tuy nhiên NAIO được giao khung chính sách/quy định trong ngắn hạn [56], [57].

Tóm lại, giai đoạn 2023 - 2025, Malaysia chọn khung tự nguyện, nâng chuẩn PDPA thay vì ban hành luật AI toàn diện ngay. Đây là cách tiếp cận tiệm tiến để xây lòng tin (trust) và năng lực tuân thủ, đồng thời không bóp nghẹt đổi mới - song cũng đặt ra yêu cầu theo dõi sát genAI và high-risk AI để cân nhắc quy định ràng buộc khi cần [53] - [57], [60], [61].

Kết luận

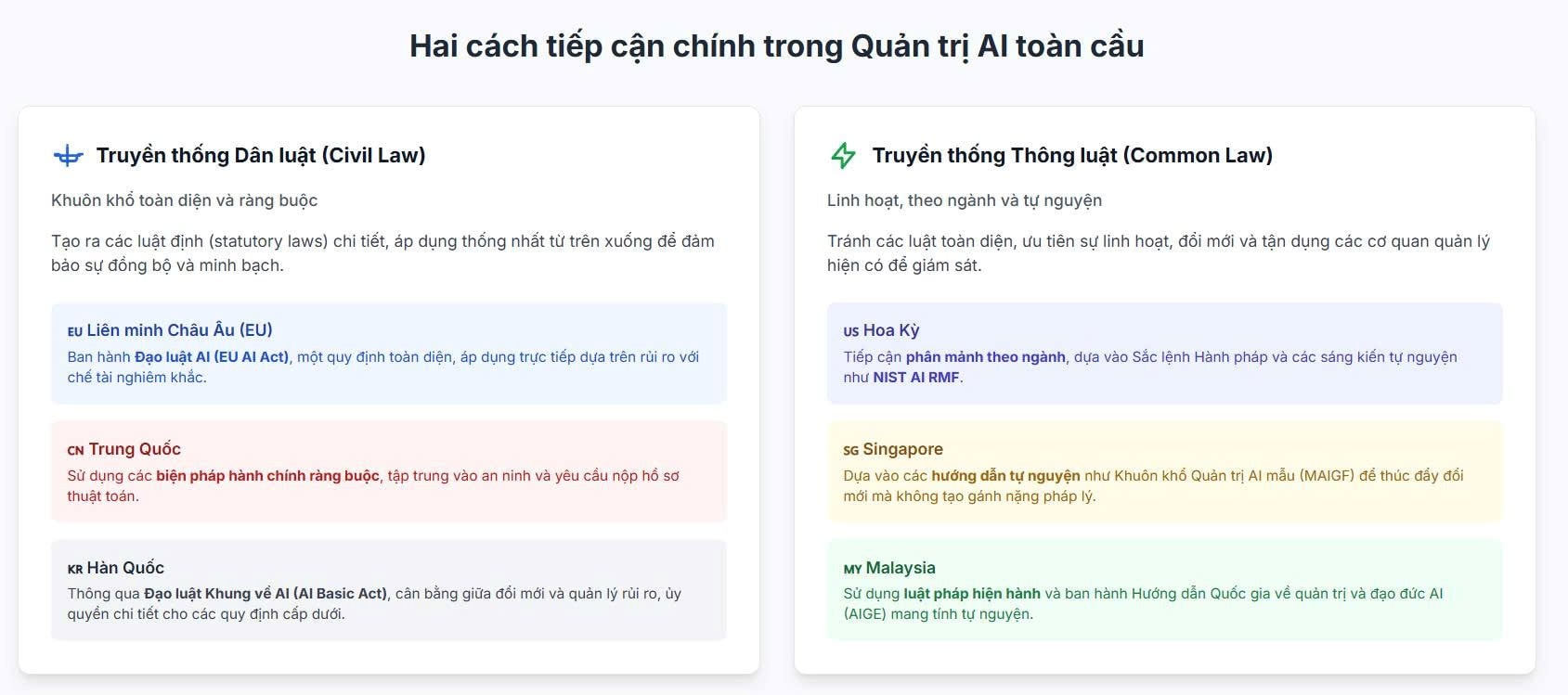

Qua các trường hợp nghiên cứu luật về AI của các quốc gia trên, có thể thấy xu hướng quản trị và lập pháp về AI trên thế giới đang hình thành hai mô hình chính:

Mô hình luật toàn diện dựa trên rủi ro:

Tiêu biểu là EU (EU AI Act) và Hàn Quốc (AI Basic Act) - những khuôn khổ pháp lý đầu tiên trên thế giới điều chỉnh AI một cách hệ thống và có tính cưỡng chế [3], [4], [7], [8].

Hai đạo luật này cùng lấy phân loại rủi ro làm trung tâm: cấm hoặc kiểm soát chặt với AI “rủi ro cao”, cho phép tự do hơn với AI “rủi ro thấp”.

Cách tiếp cận này đảm bảo an toàn, minh bạch và bảo vệ quyền con người, đồng thời yêu cầu đánh giá tác động và giám sát con người trước khi triển khai. Tuy nhiên, nó đòi hỏi năng lực quản lý và tuân thủ cao, có thể làm tăng chi phí và ảnh hưởng đến tốc độ đổi mới nếu quy định áp dụng quá rộng [3], [4], [7].

(2) Mô hình hướng dẫn mềm, linh hoạt:

Đại diện là Hoa Kỳ, Singapore và Malaysia, nơi chính phủ chưa luật hóa AI ngay mà tập trung vào khung đạo đức, nguyên tắc tự nguyện và luật hiện hành như bảo vệ dữ liệu, cạnh tranh hay tiêu dùng [1], [9], [53].

Hoa Kỳ ban hành tuyên ngôn quyền AI (AI Bill of Rights) (2022) và Sắc lệnh 14110 (2023) để thiết lập chuẩn mực đạo đức và cơ chế thử nghiệm nội bộ DN [2], [15] - [17]. Singapore triển khai Model AI Governance Framework và AI Verify, đồng thời hợp tác quốc tế qua chương trình Chương trình Thí điểm Đảm bảo AI toàn cầu (Global AI Assurance Pilot) (2025) [44] - [52].

Malaysia đi theo lộ trình “hướng dẫn trước, luật sau” với National Guidelines on AI Governance & Ethics (2024), kết hợp sửa đổi Luật PDPA 2024 để chuẩn bị nền tảng cho khung pháp lý ràng buộc trong tương lai [53] - [61]. Cách làm này tạo điều kiện cho đổi mới và thử nghiệm chính sách, song có thể thiếu cơ chế cưỡng chế đủ mạnh trước các rủi ro mới của AI tạo sinh [9].

Các điểm chung

Dù có sự khác biệt trong mức độ điều tiết, các quốc gia đều đang dần hội tụ về những thành tố cốt lõi trong quản trị AI:

Định nghĩa AI: EU chọn định nghĩa trung lập công nghệ dựa trên khả năng tự động ra quyết định [4]; Hàn Quốc định nghĩa AI theo năng lực trí tuệ mô phỏng con người [7]; trong khi Hoa Kỳ và nhiều nước ASEAN vẫn để mở định nghĩa để tránh cứng nhắc [1], [9].

Nguyên tắc nền tảng: Các văn bản của OECD, UNESCO, EU và Malaysia (AIGE) đều nhấn mạnh các giá trị chung: an toàn, minh bạch, không phân biệt, bảo vệ quyền riêng tư, trách nhiệm và giám sát của con người [3], [4], [53].

Khác biệt chính nằm ở tính ràng buộc: ở EU và Hàn Quốc là luật bắt buộc; ở Mỹ, Singapore, Malaysia là khuyến nghị tự nguyện [7], [9], [53].

Phân loại rủi ro:

EU tiên phong với mô hình 4 cấp độ rủi ro (cấm - cao - hạn chế - thấp) [4]; Hàn Quốc xác định nhóm “AI tác động cao” tương đương “rủi ro cao” [7]; Trung Quốc phân loại gián tiếp thông qua quy định đăng ký với AI có “ảnh hưởng dư luận” [30], [34].

Phân tầng này giúp tập trung nguồn lực quản lý vào lĩnh vực nhạy cảm như y tế, tư pháp, giao thông, tránh điều tiết tràn lan.

Minh bạch và gắn nhãn:

Là yêu cầu chung toàn cầu. EU và Hàn Quốc buộc phải gắn nhãn nội dung AI tạo sinh hoặc deepfake [3], [7]; Trung Quốc bắt buộc gắn watermark và xác thực danh tính [30]; Malaysia, Singapore khuyến nghị DN thông báo người dùng khi tương tác với AI [9], [53].

Đây được xem là điều kiện tối thiểu để xây dựng niềm tin và cho phép xã hội giám sát.

Trách nhiệm và giải trình:

EU và Hàn Quốc quy định rõ nghĩa vụ của nhà cung cấp và người dùng AI cùng chế tài tương ứng [4], [7]. Mỹ, Singapore và Malaysia lại dựa trên đạo đức nghề nghiệp và cơ chế tự kiểm [9], [15], [53].

Xu hướng chung là yêu cầu đánh giá tác động và rủi ro trước khi triển khai AI trong lĩnh vực nhạy cảm (bắt buộc ở EU/Hàn Quốc, khuyến nghị ở Malaysia) [5], [7], [53].

AI tạo sinh (Generative AI): Từ năm 2023, hầu hết chính sách mới đều bổ sung phần về GenAI:

Chống nội dung sai lệch: Gắn nhãn đầu ra và phát triển watermark (EU, Trung Quốc, Hàn Quốc, Hoa Kỳ EO 14110) [2], [3], [6], [7].

Quản lý dữ liệu huấn luyện: EU yêu cầu công khai dữ liệu có bản quyền [3]; Trung Quốc quy định kiểm soát chất lượng và nội dung dữ liệu [30]; Singapore và Malaysia khuyến khích công bố thông tin và bảo vệ bản quyền [48], [53].

Đánh giá và đăng ký: Trung Quốc yêu cầu đánh giá an ninh cho AI tạo sinh có “ảnh hưởng dư luận” [30]; EU bắt buộc đánh giá mô hình nền tảng (foundation models) trước khi thương mại hóa [3].

Cam kết DN: Các công ty AI lớn (OpenAI, Google, Microsoft…) đều ký cam kết tự nguyện với chính phủ Hoa Kỳ để kiểm thử an toàn và gắn nhãn sản phẩm [16].

Chế tài xử phạt:

EU quy định mức phạt nặng nhất thế giới (tới 7% doanh thu toàn cầu) [26]; Hàn Quốc phạt mức vừa phải (khoảng 30 triệu won) [7]; Trung Quốc dùng khung phạt của các luật an ninh mạng, dữ liệu, và thông tin cá nhân [6]; Singapore và Malaysia hiện chưa có chế tài riêng cho AI mà xử lý qua luật chung (như PDPA) [9], [60].

Điều này thể hiện mức độ ưu tiên: EU chú trọng răn đe, Hàn Quốc và ASEAN ưu tiên khuyến khích tuân thủ, còn Trung Quốc kết hợp kiểm soát và an ninh quốc gia.

Trên bình diện toàn cầu, quản trị AI đang dịch chuyển từ “nguyên tắc mềm” sang “luật cứng”, với EU và Hàn Quốc dẫn đầu trong việc luật hóa, trong khi Hoa Kỳ và Đông Nam Á vẫn ưu tiên linh hoạt.

Điểm hội tụ là các nước đều hướng đến AI minh bạch, an toàn và có trách nhiệm, lấy con người làm trung tâm.

Hai cách tiếp cận chính trong quản trị AI toàn cầu

Hai cách tiếp cận chính trong quản trị AI toàn cầu

Đề xuất mô hình quản trị AI cho Việt Nam

Đề xuất mô hình quản trị AI cho Việt Nam

Dự báo, từ giai đoạn 2025 - 2027, nhiều quốc gia ASEAN (trong đó có Malaysia và Singapore) sẽ chuyển dần từ khung tự nguyện sang các đạo luật AI bán ràng buộc, học hỏi cấu trúc phân loại rủi ro của EU và tiêu chuẩn kỹ thuật của OECD [9], [53], [20].

Như vậy, luật AI toàn cầu đang tiến hóa theo hướng đồng quy: đa dạng về cách thực thi, nhưng thống nhất về giá trị cốt lõi: minh bạch, công bằng, và trách nhiệm giải trình.

|

Tài liệu tham khảo Các nguồn dưới đây được trình bày theo chuẩn IEEE và đã được xác minh tính hợp lệ tại thời điểm 12/10/2025. Vì phần lớn là tài liệu điện tử (trang web, báo cáo trực tuyến, thông cáo báo chí), địa chỉ truy cập có thể thay đổi sau khi bài viết được xuất bản. Độc giả được khuyến nghị tra cứu tài liệu theo tên đầy đủ, tổ chức phát hành và ngày công bố nếu liên kết không còn hoạt động. |